AWS Step Functionsレシピ集

TECHSCORE

2022-06-02 11:00:00

はじめに AWSで定期的なデータ連携バッチを書く方法の一つにAWS Step Functions(以下Step Functions)があります。Step FunctionsはAWS Lambda(以下Lambda)を始めとするAWSの様々なサービスを組み合わせたワークフローを記述できるサービスです。LambdaおよびStep Functionsはバッチ用のサーバを構築・管理する必要がなく安価にサービスを運用できるため、私のチームでも活用しています。

LambdaおよびStep Functionsにはそれぞれ制約があり工夫が必要となる場合もあります。例えばパイプラインを定義するためにASL(Amazon State Language)というDSLを使いますが、ASLで何ができるかを理解するには時間が掛かります。細かい書き方などはすぐ忘れてしまって、以前書いたのを探すのに苦労したりもします。この記事は主に自分のために、用途別の「レシピ」をまとめようというものです。

西尾 義英(ニシオ ヨシヒデ)

開発から離れていた時期もありましたが最近プロダクトづくりに戻ってきました。

データを活用できる製品・基盤づくりがテーマです。

概要 後の説明のためにStep Functionsで取り扱う概念や用語について説明します。

ワークフロー Step Functionsではいわゆるパイプライン、つまり複数の処理を有向無循環グラフ(DAG)でつなげたワークフローを書けます。開発者ガイドではワークフローのことを状態遷移機械(state machine)、個々の処理を状態(state)またはタスク(task)と呼んでいます。状態遷移図で書いたワークフローの例を示します。

処理の始まりは「Start At: タスク名」で宣言します 最後のstateには「End: true」という属性を付与します あるstateの直後に起動する stateを「Next」で指定します 「Next」は一つだけ指定できますが、分岐やループなどの制御を実現する特別な stateがあります(下図) 分岐やループの中身が一つ以上の stateをもったサブ状態群となる場合があります データの流れ state間の入出力は JSON形式のテキストで、Lambdaとの連携が自然に行なえます。デベロッパーズガイドでは payloadと呼ばれることがあります。デフォルトではstateに入力されたJSONがそのままLambdaに渡り、Lambdaの出力が次のstateに渡ることになりますが、ASLの中でJSONを定義し直したり、JSONPath を使って抽出・変形することもできます。設定が可能な箇所を以下に示します。

基本的な書き方(SAM) Step FunctionsはAWSコンソールからGUI形式で開発することもできますが、実際の開発ではAWS SAMなどを使ってコードとして記述した方が良いと思われます。SAMで開発する時の書き方を説明します。

処理を行うLambdaを書く SAMテンプレートにAWS::Serverless::Functionリソースを定義する state machineを定義するためのASLをJSONまたはYAML形式で書く 3-1. 2で定義したLambdaのARNは変数置換(substitution)が可能です template.yamlにAWS::Serverless::StateMachineリソースを定義する 4-1. ASLでの変数置換(substitution)を定義します。2のLambdaのARNを参照します。 コピペミスや、ARN(!GetAtt リソース名.Arn)ではなく論理名(!Ref リソース名)を書いてしまう誤りが起こりがち 4-2. Lambdaを呼び出せるようなRoleを定義します # main.asl.yaml StartAt: Task1 States: Task1: Type: Task Comment: | 2.で定義した AWS::Serverless::Function を呼び出します。 Resource: ${TaskFunctionArn} End: true # template.yaml(一部) TaskFunction: #2. Type: AWS::Serverless::Function ~省略~ BatchStateMachine: Type: AWS::Serverless::StateMachine Properties: statemachines/main.asl.yaml DefinitionUri: statemachines/main.asl.yaml DefinitionSubstitutions: #4-1. TaskFunctionArn: !GetAtt TaskFunction.Arn #3-1. Role: !GetAtt BatchStateMachineRole.Arn #4-2. BatchStateMachineRole: #4-2. Type: AWS::IAM::Role Properties: AssumeRolePolicyDocument: Version: '2012-10-17' Statement: - Sid: StsAssumeRole Effect: Allow Principal: Service: states.amazonaws.com Action: sts:AssumeRole Path: / Policies: - PolicyName: InvokeLambdas PolicyDocument: Version: '2012-10-17' Statement: - Effect: Allow Action: - lambda:InvokeFunction Resource: "*" Lambda以外のサービスと連携(SNSで通知) LambdaはResourceにARNを書くだけで連携できますが、Lambda以外のサービスを呼び出すこともできます。以下はSNSで通知を行う例です。

Publish Success to SNS: Type: Task Resource: arn:aws:states:::sns:publish Comment: | SNSでバッチ処理成功を通知する。 件名や本文には固定の文字列だけでなく payload(の一部)を指定することもできる。 Parameters: Subject: Batch job succeeded Message: $.result TopicArn: $SuccessTopicArn End: true State Machineの分割 状態遷移の数に制限があったり、ASLが長すぎて読みづらい、複数のstateで発生する例外をまとめて一箇所でキャッチしたいなど、いくつかの理由からASLを分割してサブルーチンのように呼び出す場合があります。

# main.asl.yaml Process Purchases: Type: Task Resource: arn:aws:states:::states:startExecution.sync # StateMachineを同期的に呼び出す組み込みTask。後ろの`.sync`がポイント Parameters: StateMachineArn: ${PurchasesStateMachineArn} # 呼び出すStateMachineのARN Input: # StateMachineにわたすPayload updated.$: $.updated from.$: $.from sales_detail.$: $.keys.sales_detail ResultPath: null # StateMachineからのoutputは入れ子が深く使いにくいので破棄してしまう Catch: # 呼び出したStateMachineのどこかで例外が発生したらここでまとめてキャッチできる - ErrorEquals: ["States.TaskFailed"] Next: Publish Failure to SNS End: true StateMachineからStateMachineを呼び出すにはStateMachineのRoleにポリシーが必要です。詳細は https://docs.aws.amazon.com/ja_jp/step-functions/latest/dg/stepfunctions-iam.html に説明されています。

入出力 {Input|Output}Pathの指定方法 以下のパターンを使い分ければおおよそ大丈夫かと思います。詳細はリファレンスを参照。

加工前 Path 加工後(Python object) {"input": "somevalue"} "$" {"input": "somevalue"} {"input": "somevalue"} null None {"input": "somevalue"} "$.input" "somevalue" {"parent": {"child1": "v1", "child2": "v2"}} "$.parent.child1" "v1" | | | [1, 2, 3] "$[0]" 1 ResultPathの意味 InputPathやOutputPathの指定は、入力されたJSONのどの要素を取り出すかを意味しますが、ResultPathは、stateから出力されるJSONのどこに結果を挿入するかを指定します。以下の3つの使い方があります。

ResultPath: $ $はJSONのroot要素を意味します。つまり入力されたJSONを破棄して結果で上書きします ResultPath: null 逆に挿入先を指定しないということは、結果を破棄し入力されたJSONをそのまま出力する意味です 入力されたJSONの要素に結果をマージする ResultPath: $.resultは、入力されたJSONに"result"という要素を追加します。 3の入力例

{ "job_id": 1, "process_at": "2022-04-01T00:00:00+09:00" } 3の出力例

{ "job_id": 1, "process_at": "2022-04-01T00:00:00+09:00", "result": { "status": 200, "key": "processed.json" } } {Parameters|ResultSelector}の指定方法 出力したいJSONをそのまま書けばよいのですが、入力されたJSONを参照する時だけプロパティ名の末尾に.$を付けるのがポイントです。

同じく詳細は https://states-language.net/spec.html#payload-template を参照。

# 指定例 Parameters: flagged: true parts: first.$: $.vals[0] last3.$: $.vals[3:] 同期的な制御 ファイルの分割処理 Map stateは、JSON配列の要素ごとの処理を記述することができます。可能な場合は各タスクは並行に実行されるので、ループと言うよりMap-ReduceのMapに相当します。Mapへの入力が [1, 2, 3]の場合、Map下のIterator先頭のstateは1, 2, 3をそれぞれ受け取ります。他のパラメータが必要な場合、ItemsPathを使って配列を参照するJSONPathを指定するとともに、MapのParametersに子のTaskが受け取るJSONを定義することができます。

よくある使い方は、Lambdaのメモリまたは実行時間の制約のためデータを分割処理する場合です。

# ファイルの分割処理 1.Split Users in Files: Type: Task Resource: ${SplitUsersInFilesFunctionArn} Comment: | 入力されたファイルを固定行数で分割してS3に保存。 input: key_users(str): 処理するファイルを取り出すS3キー output: s3_keys(array of str): 分割したファイルのS3キー ResultPath: $.s3_keys # <-- ここに配列を入れる Next: 2.Import Users } 2.Import Users: Type: Map ItemsPath: $.s3_keys # ここから配列を取り出す Parameters: job_id.$: $.job_id # バッチ全体の共通変数 s3_key.$: $$.Map.Item.Value # Iteratorが受け取る配列要素(ItemsPathで指定)を参照する ResultPath: null # 実行結果は捨てる MaxConcurrency: 1 # 並行実行させない場合単なるループ処理 Next: 3.Another process Iterator: StartAt: Load Database States: Load Database: Type: Task Resource: ${LoadDatabaseFunctionArn} Comment: | 入力されたファイル一つをデータベースにロードする。 input: job_id(int): ジョブID s3_key(str): 処理するファイルを取り出すS3キー output: なし End: true 3.Another process: # 省略 固定回ループする ItemPathは、State間で受け渡されるJSONの一部を指定することができるのみで、固定要素の繰り返しを書くことができませんが、Passを組み合わせると実現できます。

Enumerate Reset Data: Type: Pass Comment: | ループ変数を生成 input: job_id(int): ジョブID output: types(array of str): 処理するデータの種類 Result: ["customers", "purchases", "purchase_items"] ResultPath: $.types # 上の配列をこのPathで参照できるようにする Next: Reset Data Reset Data: Type: Map ItemsPath: $.types # ループで回したい要素 Parameters: job_id: $.job_id type.$: $$.Map.Item.Value ResultPath: null # 結果は捨てる End: true Iterator: StartAt: Revert Data States: Revert Data: Type: Task Resource: ${RevertDataFunctionArn} Comment: | 指定された種類のデータをリセットする input: job_id(int): ジョブID type(str): 処理するデータの種類 output: なし ResultPath: null End: true カウンタを使ったループ Stepfunctionsで Choiceが分岐を書けるのでループを実現することはできますが、複雑なので基本的には Mapを使うことを考えたほうが良いと思います。 https://docs.aws.amazon.com/ja_jp/step-functions/latest/dg/tutorial-create-iterate-pattern-section.html

入力が空だったら終了 Concatenate: Type: Task Resource: ${ConcatenatePurchasesFunctionArn} Comment: | 日次に分割されたファイルを結合する input: job_id(int): ジョブID keys(array of str): ファイルを取り出すS3のキー output: key(str | null): 結合した結果を保存したS3のキー。入力されるファイルが0件ならnull ResultPath: $.key Next: Test Empty Data # 処理するデータが空なら終了させたい Test Empty Data: Type: Choice # 分岐を書く Choices: - Variable: $.key # 評価した値のPath IsNull: true # 評価式 Next: Return If Empty # 当てはまった場合の遷移先 Default: Convert Date # 全ての Choice要素 の評価が失敗した場合の遷移先 Return If Empty: { Type: Succeed } # 終端のState。Succeedは何もせずここで状態遷移が正常に終了したことを表す Lambdaの実行結果で分岐する Step FunctionsはLambdaの例外をキャッチして分岐することもできますが、Lambdaの出力結果で処理を継続するか失敗させるかを判断したい場合はChoice stateで分岐を書くこともできます。

Tell Status : Type: Task Resource: ${TellStatusFunctionArn} ResultPath: $.result # {statusCode: 200} または {statusCode: 500} Next: Check Status Check Status: Type: Choice Choices: - Variable: $.result.statusCode <-- ここで取り出す NumericEquals: 500 Next: FailState Default: SuccessState SuccessState: { Type: Succeed } FailState: { Type: Fail } 非同期処理 子のStateMachineの完了を待たない 別のStateMachineを呼び出す方法については「State Machineの分割」で説明しました。子のStateMachineの完了を待ちたい場合が多いですが、待たずに終了してしまうこともできます。

Delegate: Type: Task Resource: arn:aws:states:::states:startExecution # 非同期実行 Parameters: StateMachineArn: ${IntegrationStateMachineArn} Input: updated.$: $.updated job_id.$: $.job_id End: true SNSやEvent、SQSから復帰する StateMachineから明示的にLambdaやStateMachineを起動せずにSNSなどで間接的に処理を起動する場合、普通はそのまま制御が戻ってきませんが、必要であればコールバックしてもらうことができます。 https://docs.aws.amazon.com/ja_jp/step-functions/latest/dg/callback-task-sample-sqs.html に解説されていますが、Stepfunctionsから制御の外れてしまったLambdaからトークン付きのコールバックを待ち受けることができます。

実装例 初期化バッチが特定のS3バケットにデータを投げると、自動的に取り込み処理が走ります。取り込みが完了すると初期化バッチに処理が戻り、別の処理を続けます。少々複雑な例ですが、トークンを複数のLambda間でリレーできます。なお、LambdaのコードはPython3.8ランタイム向けのものです。

# main.asl.yaml StartAt: Upload Datalake States: Upload Datalake: Type: Task Comment: | S3バケットにファイルをアップロードする。 アップロードした後はバケットのOnPlaceイベントで別のLambdaが呼び出される。 そちらの処理が終わるとtask_tokenをもってコールバックされて次のTaskへ遷移。 Resource: arn:aws:states:::lambda:invoke.waitForTaskToken HeartbeatSeconds: 60 # https://docs.aws.amazon.com/ja_jp/step-functions/latest/dg/connect-to-resource.html#wait-token-hearbeat Parameters: FunctionName: ${UploadFunctionArn} Payload: task_token.$: $$.Task.Token Next: Do Something # 省略 BucketXInput: # ファイルを置くバケット Type: AWS::S3::Bucket Properties: NotificationConfiguration: TopicConfigurations: - Event: 's3:ObjectCreated:Put' Topic: !Ref TopicXOnPlaceFile TopicXOnPlaceFile: # 通知内容 Type: AWS::SNS::Topic FunctionPermissionXOnPlaceFile: # SNSきっかけでLambdaを起動する場合に必要 Type: AWS::Lambda::Permission Properties: Action: lambda:* #InvokeFunction FunctionName: !GetAtt FunctionXOnPlaceFile.Arn Principal: sns.amazonaws.com SourceArn: !Ref TopicXOnPlaceFile SubscriptionXOnPlaceFile: # SNS::TopicにLambdaをひもづける Type: AWS::SNS::Subscription Properties: Endpoint: !GetAtt FunctionXOnPlaceFile.Arn Protocol: lambda TopicArn: !Ref TopicXOnPlaceFile FunctionXOnPlaceFile: # ファイルが設置されたときに呼ばれる関数 Type: AWS::Serverless::Function Properties: CodeUrl: src/ Handler: on_place.lambda_handler # 省略 InvokeConfigXOnPlaceFile: # FunctionXOnPlaceFileの実行が成功・失敗した場合にSNS通知する設定 Type: AWS::Lambda::EventInvokeConfig Properties: FunctionName: !Ref FunctionXOnPlaceFile MaximumRetryAttempts: 0 DestinationConfig: OnSuccess: Destination: !Ref TopicXOnSuccess OnFailure: Destination: !Ref TopicXOnFailure # 以下省略 Qualifier: "$LATEST" TopicXOnSuccess: Type: AWS::SNS::Topic SubscriptionXOnSuccess: Type: AWS::SNS::Subscription Properties: Endpoint: !GetAtt FunctionXOnResult.Arn Protocol: lambda TopicArn: !Ref TopicXOnSuccess FunctionXOnResult: # 関数の処理が成功あるいは失敗したときに呼ばれる関数 Type: AWS::Serverless::Function Properties: CodeUrl: src/ Handler: on_result.lambda_handler # 省略 # src/main.py def lambda_handler(event: LambdaEvent, context: LambdaContext) -> None: result = parse_sns(event) print("do something") if result.task_token is None: return # 常にstateMachineに戻る必要はない try: # TODO 失敗時にsend_task_failureしたほうが良い sfn_client = boto3.client("stepfunctions") sfn_client.send_task_success( taskToken=result.task_token, output=result.to_json() ) except Exception as e: print(e) def parse_sns(event: LambdaEvent) -> ResultOutput: # ResultOutput は、on_place_file Lambdaの戻り値をラップしたdataclass record = event['Records'][0] message = json.loads(record['Sns']['Message']) payload = message["responsePayload"] return ResultOutput.from_dict(payload) コールバックするための権限が必要です。on_result lambda のRoleに以下Policyを追加します。

- PolicyName: StateMachineCallback PolicyDocument: Version: '2012-10-17' Statement: - Effect: Allow Action: - states:SendTaskSuccess Resource: "*" おわりに 私たちがプロジェクト内で使っているパターンはおおよそこんなところです。最後にStep Functionsを使うときのポイントをまとめます。

ASLはYAMLで書くのがおすすめ カッコやクォーテーションを書く量が減る 行コメントも書ける 繰り返し処理は、まず Map の利用を考える Mapはデフォルト並列実行しようとするので注意 大きくなってきたらStep Functionsを分割する 見通しを良くするため 状態遷移数の上限に引っかかることもある Payloadの加工を良く間違うので、ワークフローを流れるJSONの構造を先に決めておくと良い pydanticを使ってタスク間で共有するJSONをPythonのクラスに対応付けておき、Lambda間で共有する この方法がまとまったらまた記事を書くかもしれません 複雑なワークフローを組む場合、Lambdaで時間がかかる処理を書く前にTask間の入出力を確かめておくと良い Pass stateを使って状態遷移だけ作っておく 中身のない入出力だけのLambdaを定義する

プロダクト開発におけるプロジェクトマネジメント

TECHSCORE

2022-05-26 11:00:00

当社が提供しているSynergy!(顧客管理・CRMシステム)の開発プロジェクトのPMを担当しています。 今回は主にプロダクト開発の進め方について、これまで試行錯誤してきた内容を書きたいと思います。

下山 倫央(シモヤマ トモヒサ)

2007年に入社後、SI案件の営業やプロジェクトマネージャーを経て、現在はSynergy!のプロジェクトマネージャーとしてプロダクト開発に携わっています。 最近は子供中心の生活です。毎日2人の娘に癒されています。 プロダクト開発の進め方 以前のプロダクト開発は、企画や仕様を決める作業や、開発を実施する作業など、各工程で役割を分担する進め方で行っていました。

以前の開発フロー概要 企画された機能に対してデザイナーがワイヤーフレーム/デザインカンプ*1、画面仕様書を作成 PMがレビュー エンジニアなどの関係者にワイヤーフレーム/デザインカンプ、画面仕様書の説明を実施 開発着手~テスト~リリース ただ、この進め方だと、

仕様が完全に決まらないと開発が進まない ⇒エンジニアが稼働できず、リソースを最大限活用できない PMとデザイナーだけで仕様を検討している ⇒エンジニアなどの関係者との仕様の認識ずれや仕様検討の後戻りが多い デザイナーがワイヤーフレーム/デザインカンプ、画面仕様書を作成している ⇒仕様確認や画面仕様書の修正など、デザイナーの負荷が高い というような課題が出てきました。 そこで、PM、エンジニア、デザイナー、QA(Quality Assurance)などプロジェクトに関わる関係者が一緒に仕様を検討しながら開発を進めるフローに変更しました。

現在の開発フロー概要 PMが仕様検討のもとになるPBI(プロダクトバックログアイテム)を作成※この時点でエンジニアに仕様の調査や確認を依頼することもあります デザイナーがPBIを元にワイヤーフレーム/デザインカンプを作成 PM、エンジニア、デザイナー、QAでPBIとワイヤーフレーム/デザインカンプを元に仕様検討を実施(リファインメント) 仕様検討結果をPBI、ワイヤーフレーム/デザインカンプに反映 PMが画面仕様書を作成 エンジニアがタスクを洗い出す(プランニング)※PBIとタスクをGitLabのissue boardを使ってカンバン運用*2しています 開発着手~テスト~リリース 開発フローを変更して良かったこと 現在私が担当しているプロジェクトではフローを変更したことにより、下記のような効果がありました。

エンジニアを含め関係者全員で仕様検討を行うため、エンジニアのリソースも最大限活かせる さらに、認識のずれや仕様検討の後戻りが少なくなり、仕様検討の過程も記録することで 関係者全員で振り返ることができるようになった どこかの役割に負荷が集中することなく、進捗がスムーズになった これまでは、「PM・デザイナーが仕様書を作成して、その仕様でエンジニアに開発を発注する」という感じがありましたが、プロジェクトの関係者が一緒に仕様検討を進めることで、以前に比べチームとしての一体感が生まれてきたと感じています。

運用していくうえで見えてきた課題 ただし、良いことばかりではなく、新たな課題も見えてきました。

PBI単位で仕様を検討していくため、将来の全体感が見えない デザインに関しては直近リリースを行う機能だけではなく、今後リリースされる機能も含めて整合性をとって設計する必要があるため、現在の進め方には課題があります。 一部、将来リリース予定の機能をデザイナーが前倒しすることにより対応している箇所もありますが、この点については今後対応方法を検討する必要があると考えています。

複数のプロジェクトが稼働しているが、プロジェクト間で運用に少しずつ違いが出てきた 運用を変更してから1年ほどたちますが、下記の点についてプロジェクト間で差異がでてきました。

PBIに記載する内容 スケジュール管理方法 PM、エンジニア、デザイナーの役割 リリース機能に対するフィードバックやバックログの管理方法 各種会議体のファシリテーター など この件に関しては、明確なルールが決まっていなかったことが原因ですので、各PMが集まって情報交換を行い、ルール決めや運用方法の改善に取り組んでいます。 また、各種フォーマットを整備し、プロジェクト間で運用に違いが出ないような取り組みも進めています。

今後について 現在の運用が最適とは考えていません。 仕様決定のプロセス、プロジェクト間の情報共有、各職種間のコミュニケーションなど、まだまだ改善が必要なものがあります。関係者でプロジェクトの振り返りを実施し、当社にとってより良い運用方法を模索していきたいと考えています。

*1:ワイヤーフレームを元に作成したデザインの完成見本(色、フォント、レイアウトが決定しているもの)

*2:タスクごとにカード(カンバン)を作成し、作業工程や進捗状況ごとにボードで管理する運用方法

Synergy!のシステム障害における情報共有の改善プロジェクト

TECHSCORE

2022-05-19 11:00:00

川島 吉久(かわしま よしひさ)

2004年入社。

Javaプログラマから始まり、SE、プロジェクトマネージャー、テクニカルサポートを経て、現在はSynergy!のプロダクトマネージャー。 当社はメール配信やフォーム作成のできるクラウドサービスのSynergy!を提供しており、Synergy!にシステム障害が発生すると、お客様から様々なお問い合わせをいただきます。 原因は何か、いつ復旧するのか、フォームに登録はできるのか、予約しているメール配信は予定通り行われるのか、配信途中のメールはどういう状況なのか、APIはエラーになっていないか、データ連携は問題ないか、などなど。 それらに正確かつ迅速に回答すべく、障害発生中の情報共有における課題改善に取り組んでいます。

情報共有の流れ 障害発生時、当社では主に

エンジニア 原因調査や復旧、影響調査を担当します 障害対策PM(プロジェクトマネージャー) 障害発生時の情報集約を担当します カスタマーサポート・営業 お客様からのお問い合わせに回答したり、障害状況をお知らせします の役割に分かれて、

エンジニア → 障害対策PM → カスタマーサポート・営業 の流れで調査状況、復旧の進捗などを情報共有します。 筆者は障害対策PMを担っています。

課題と改善 これまで何度か障害対策PMを担ってきましたが、対応する中でいくつかの課題が顕在化したため、改善案を検討しました。

エンジニアによる復旧作業や影響調査などの進捗状況が分かりにくい こちらは、エンジニアと障害対策PM間のコミュニケーションの課題です。

復旧作業や影響調査が完了した際にはエンジニアが報告用チャットで障害対策PMに連絡してくれるのですが、障害が長引く場合は次の対応を準備したり、対応の優先順位を検討するために進捗状況も知りたいところです。 オフィスに出社していたころは、エンジニアの集まっているところに寄っていけば状況を把握できたのですが、在宅勤務が中心となってからはエンジニアごとに別々のチャットで相談したり調査・復旧を進めているため、「エンジニアの集まっているところ」を知ることが難しくなってしまいました。 障害対策PMとしては、だれがどのチャットで何を作業してくれているのか、調査や復旧の進捗状況が分かりにくい状態でした。

そこで、定期的に情報を共有してもらうオンライン会議を開くことにしました。これにより、「調査完了」や「復旧完了」などの完了連絡だけでなく、「今はまだ原因究明の目途がたたないが、ここが怪しいのでこれから調べるつもり」や「あと30分くらいで影響調査は終わりそう」などの途中経過を知ることができるのではないかと考えています。ただ、開催頻度を高めすぎると調査や復旧の手を止めてしまうことにもなりかねないので、どのくらいの頻度で開催するのが最適なのかはこれから試行錯誤していく予定です。

最新情報を追いかけにくい 次は営業・カスタマーサポートと障害対策PMとのコミュニケーションの課題です。

こちらもチャットを利用して情報を共有するのですが、質疑応答などの会話が進むとどうしても大事な情報が流れていってしまって、何が最新情報なのか、重要な情報を追いかけにくい状態になりがちでした。

そこで、当社で利用しているナレッジ共有ツールDocbaseを利用して、常に最新情報を更新するページを設けることにしました。また調査や復旧の進捗状況もここに記録していくことで、後から障害報告書にまとめるときにも情報が参照しやすくなります。

調査結果をまとめるのに時間がかかる 最後は障害対策PMの課題です。

エンジニアがエラーログなどから影響調査してくれた結果を、お客様からのお問い合わせを対応するカスタマーサポート・営業に共有するのですが、ログの集計結果だけではアカウントIDしか情報がないため、そこにお客様名や担当営業などの情報を追加します。その作業を障害対策PMが担っているのですが、手作業なため共有までに時間がかかっていました。

そこで、エンジニアの調査結果(抽出項目や集計軸、表示する順番など)を定型化してもらい、追加するお客様情報も自動で参照できるよう影響調査シートのフォーマットを固定しました。 まだすべての機能について定型化できていないのですが、これまでより大幅に時間短縮できる見込みですし、手作業のミスもなくなると考えています。 また、エンジニアの調査結果を定型化するため、調査コマンド自体も定型化されることで、副産物として調査の属人性を排除することもできそうです。

最後に 障害は起きないことが一番ですが、色々な要因があり完全になくすことは難しいため、発生してしまった場合はできるだけ早く復旧することを目指してエンジニアたちが頑張ってくれています。 その努力を少しでも活かせるように障害対策PMとしては、引き続き迅速・正確なコミュニケーションを目指します。

新人エンジニアに伝えたいこと - エンジニアリングを楽しむための3つのコツ -

TECHSCORE

2022-04-21 11:00:00

こんにちは、CTO の馬場です。 4月です。今年も当社に7名の新卒が入社しました。振り返ると、私は毎年新卒の総合職の方向けに話す機会をもらっているのですが、技術職の方向けに話す機会がないんですよね。なぜだ。

ということで、当社の技術者に期待することを書き記したいと思います。

馬場 彩子(ババ アヤコ)

2001年入社のシナジーマーケティング最古のエンジニア(ほんとは2番目)。

私が新卒で会社に入社したのは1999年。前世紀です。2000年になるとコンピューターが誤作動して世界が破滅する、という「Y2K問題」というのがあり、年末年始待機していたことを覚えています。懐かしい。

すきなものはビールとカニ。きらいなものはチーズ。 「学習」をアップデートする ひとことでいうと、みなさんに期待することは学習をアップデートすることです。ようやく学校を卒業したのにまた「学習」か……早く人や社会に貢献することをしたいんだ...… という方。実は、「学習」という言葉は、この10年でかなり意味合いが変化した言葉です。*1

以前の学習といえば、先人たちが発見した正解の知識を自分にインストールすることを指しました。学校では、授業を受け、演習をこなし、テストを受けて習熟度を測る、このような学習を実施してきたと思います。もちろん、知識は財産になります。一般的に暗記できるような事実だけでなく、視点・観点やロジックですら、知識として身につけることができます。ただし、 VUCA の時代においては、みなさんにお願いする仕事のほとんどは「誰もやったことないこと」「正解がわからないこと」だったりします。教科書の後ろの方のページをみても解答例がないような問題に、どうやって立ち向かったらいいのか。その試行錯誤、暗中模索の足掻き方と足掻くだけの筋力を身につけることが、「学習をアップデートする」ことです。

3つの行動指針 じゃあ具体的にどうしたらいいのか、というと、3つあります。

わからないこと、できないこと を楽しむ 目の前の人を理解する 自分の意志を表明する わからないこと、できないことを楽しむ 新卒のこの時期は、新人研修などではじめてのことを山ほど体験しているころだと思います。はじめてのことって上手くできないですよね。私は、以前は(いまも?)かなりの負けず嫌いだったので、他の人と比べてできないことは避け、できそうなことや慣れ親しんでいることを繰り返しがちでした。わからない、できない、知らない、やったことないことって本当に居心地悪い。身につけたスキルで楽々暮らしていきたい。

ただ、この2年ほどの当社の開発では、やったことないことしかやってないんです。世界がどんどん変わっていく中、前例が役立たずになったり、やっていることが通用しなかったり、通用しなくなることが明らかになってきたりしています。現サービスを維持するという保守的な目標を立てたとしても、我々の技術をどんどん変えていく覚悟が必要です。みなさんはそんなチームにこれから配属されるので、ずっと「わからない仕事」、「やったことない仕事」と向き合うことになります。ふふふ。

なので、はやく「わからない」「やったことない」をてなずけて、楽しめるようになってほしいと思います。振り返ると、私自身、聞いた途端「これ、無理」と即答するような、目の前になんのとっかかりもないつるっつるの壁が立ちはだかっていると錯覚するような、そんな無茶振りこそ、あとに忘れられないことになったりしています。そして自分がどんどん成長していくんで、とても楽しいんですよ。

有名なタモリさんのセリフもありますので、ぜひ怯まないでChallenge してください。

自分の中で『これくらいの力がついたら、これくらいの仕事をしよう』と思っても、その仕事は来ない。必ず実力よりも高めの仕事が来る。それは「チャンス」だから、絶対怯んじゃだめ。

目の前の人を理解する そんな誰もやったことない仕事に対して、どうやって最初のとっかかりを見つけたらいいのかというと、まずは課題を深く理解することです。

私たちは、ソフトウェアを提供することによりお客様の課題を解決することで、お金をいただいています。とはいうものの、いつでも先の先の先のお客様に想いを馳せろ、というのは難しいですよね。理解するってそんなに簡単なことではありません。

新卒エンジニアであれば、おそらく最初は先輩や上司から仕事を依頼されることが多いでしょう。なので、まずは目の前の仕事を依頼してきた人が、なぜこのタイミングでそのタスクをあなたに完了させてほしいと思ったのか、考えましょう。 このとき、相手のことを考えるだけでは不十分です。相手の立場になって、相手になりきって考えてみることがコツです。

これを、Synergy!プロダクトオーナーの岡村さんが「憑依させる」とよく表現するんですよね。自分以外の、立場も知識も違う人の思考の流れをトレースするイメージです。私もすぐ自分の思考にすっと流れてしまうのですが、本質を捉えるためにも意識したいことです。

自分の意志を表明する さて、最後はアウトプットです。わからないという不安を乗り越え、依頼の本質を理解するために一回思考したら、きっとなんとか答えをひねりだすことでしょう。でもそれはかなり頼りないアウトプットにみえると思います。これで本当にいいのか、なにか決定的に間違えてるんじゃないのか、時間いっぱいまで完璧に近づけようと、同期に聞いてみたり、Google で調べてみたりしてしまうこともあると思います。

でも、仕事に唯一無二の正解は存在しません。そして、正解のない世界では、スピーディにベターな方法を選択して試していくことが求められます。そのためには、チームで協調して知恵をしぼるんです。自分一人でやらなくていい。ただ、「わからないので、先輩に答えを聞く」も違います。なぜなら、あなたも知恵をしぼるチームの一員だからです。自分の理解から「答えはこうなんじゃないか?」という仮説をつくり、自分に仕事を依頼した人にぶつけてみましょう。

メンバーそれぞれが意志をもち、それを表明していくことにより、チームが相乗効果を発揮できるようになります。新人のうちは意見を求められることは少ないかもしれません。ただ、考えをまとめること、それを相手がわかるように伝えることは、それぞれスキルがいることです。知識を身につけたら、自然と自分の意志を言語化できるようになるわけではないのが、難しい。そのためには、「自分はどう考えるのか」、常に自分に問い続けること、人に話してみて、フィードバックを得ることです。経験と知識が自分の中でぐぐっとつながって広がっていきますよ。

学ぶことは楽しい 今回新卒エンジニア向けに学習について書きましたが、学習のアップデートは決して簡単なことではありません。むしろ「こうやったらうまくいった」を蓄積してしまっている我々ベテランの方が、学習プロセスそのものをアップデートすることは難しいかもしれません。

それでも、昨日、1ヶ月前、1年前の「できない」「わからない」が「できた」「わかった」「動いた」に変わるのは最高に楽しい体験で、それがエンジニアリングだと信じています。

そんな体験が少しでも増えるよう、私自身も大小さまざまな学習、チャレンジにとりくんでいきたいと思っています。この記事が新卒のみなさんの豊かなエンジニアライフのスタートの手助けになれば幸いです。

シナジーマーケティング株式会社では一緒に働く仲間を募集しています。

*1:参考図書 みんなのアンラーニング論 組織に縛られずに働く、生きる、学ぶ

社内でデータ分析基盤の勉強会を開いています

TECHSCORE

2022-03-09 11:00:00

この記事では、当社内で実施している技術勉強会について紹介します。

西尾 義英(ニシオ ヨシヒデ)

開発から離れていた時期もありましたが最近プロダクトづくりに戻ってきました。

データを活用できる製品・基盤づくりがテーマです。

過去の連載はこちら 西尾です。自社サービスで扱うデータを収集して加工・分析する仕組みを作る為、機械学習を利用した新サービスの開発を行っています。AWS上で作っているのですが、たくさんあるサービスをどう組み合わせたら良いか、また製品で使えるだけの可用性、その他品質を作り込む方法など、知識不足で課題が多いです。社内の知見を集められるようにデータ分析基盤の勉強会を行おうと考えました。

この勉強会は、データ分析基盤というものについての理解(Why,What,How)を社内に広めるきっかけとなることを期待しています。ゆくゆくは当社に必要なデータ分析基盤を構築・運用できる人材の育成や、部門間の情報共有につながればと考えています。

始める前は、機械学習を全社的に取り扱っているわけでもなく、当社の主力商品の開発チームも多忙な時期だと聞いていたので、どれくらい人が集まるか不安でした。ある機会に全社に呼びかけを行ったところ、未経験だが興味があるというメンバーがおり非常に勇気付けられました。本記事はここから彼にバトンタッチいたします。

横田 真一(ヨコタ シンイチ)

熟練の先輩エンジニアに囲まれて日々精進を続ける、しがないインフラエンジニアです。物語の冒頭によくある「元気だけが取り柄です!」みたいなキャラ説と同じ括りにしたくないのですが、好奇心だけが取り柄です。 バックグラウンド、勉強会をやろうと思った理由 第3次AIブームの火付け役となったディープラーニングの情報をネット上で目にする機会が増えたこともあって、徐々に機械学習やデータ分析基盤に興味が湧いてきました。とは言っても正しい知識は全くありません。無知の知の心構えは有るにしても「これじゃいけない。」という焦りと「本当はどういうもの?」という好奇心はありました。そこで、機械学習、DWH、MLOpsなどを扱っている西尾さんにお声がけしたところ、「データ分析基盤勉強会」という名前で会を発足することになりました。

勉強会で何を学んでいるか 勉強会は以下の目的に沿うようテーマを決めて、隔週で行いました。

データ分析とは何かを理解する なぜデータ分析が必要なのかを理解する データ分析をどのように実施するのかを理解する MLOpsとは何かを理解する AWSを利用してデータ分析基盤を構築・運用する方法に関する基礎知識を身につける 勉強会の発表者は持ち回り制です。勉強会の最後に決めた次回のテーマに沿って、習得済みの知識や、発表に向けて新たに学んだ知識を発表するという形を取りました。テーマを大きく分類すると以下の通りになりました。

機械学習に対する正しい基礎知識 AWSの機械学習及びデータ分析基盤のサービス内容と、活用例 ハンズオン会 社内での実例を知る 他の参加者の方は「機械学習に対する正しい基礎知識」という分類に属するテーマを中心に発表されていたのですが、これは私のような初学者が陥り易い「機械学習自体だけに興味が集中しがち」な状態を正すのにおおいに役立ちました。機械学習を利用したソリューションを構築しようと考えたとき、システム全体として機械学習が担う部分はごく僅かであり、その周辺の仕組みやデータの変換、移行、管理の仕方など色々学ぶ点は多く、実際に手を動かしてみたい衝動に駆られることもありました。

私は主に「AWSの機械学習及びデータ分析基盤のサービス内容と、活用例」という分類に属するテーマを中心に発表を行いました。具体的には「AWSの機械学習サービス紹介」「SageMaker の利用レポート」といった内容です。準備として、AWS サービス別資料を読み漁るのと同時に個人用アカウントでハンズオンに取り組み、自分なりに理解を深めてから、その情報を資料化して勉強会で発表するという方法を取りました。

ただ、ピンポイントで個々のサービスの知識を「点」として得ても、実務で使えるような「線」としての知識に上手く繋げられなかったので、AWS資格である「Certified Data Analytics - Specialty」の勉強を始めました。資格勉強は知識ゼロの人を対象に段階的にかつ体系的な知識を無理なく身に着けられるので、AWSのデータ分析基盤のサービスを実務で使えるようになるためにはこの勉強法が一番合っていました。

勉強会は1年続いた。モチベーションの維持など 勉強会は約1時間で前半は発表、後半は発表された内容で議論や事例を肉付けして、質疑応答を行うというよくあるパターンです。実際に業務で機械学習を扱っていない私にとって、勉強会参加者の体験談などは非常に興味深く、機能を学ぶだけでは得られない疑似体験のようなものでした。これがモチベーションの維持に大きく役立ちました。

次はこういうことを学びたい(個人的に) まずはAWSを組み合わせて一つのサービスを作り上げることを動機とした勉強に、AWS Certified Data Analytics - Specialty を選んだので取得するまで続けます。機械学習が、ソリューション全体で担う部分はごく僅かとはいっても、難解で膨大な知識が必要な分野であることは間違いありません。それゆえ、「ソリューション全体を作り上げること」、「機械学習自体」の2面での知識が必要になります。まずは、機械学習自体の学びもしたいと考えていたところ、Kaggle Expert の称号を持つ勉強会参加者がいらっしゃいまして、その方に Kaggle *1 を紹介してもらいました。せっかく紹介してもらったので、最も有名な「機械学習を使用して、タイタニックの難破船を生き延びた乗客を予測するモデル作成」をやり始めました。まだやり始めたところなのですが、実際に手を動かすことと、知識を得ることを整理すると理解しやすかったです。

勉強会で今後活かしていきたい内容(会社として) 私はインフラエンジニアとしてSynergy!のプラットフォームを管理する部署に所属しています。今はデータ分析基盤の知識は必要ないのですが、今後機械学習を用いた製品の展開がなされたら必要になると考えています。自部署内でも、ログ分析、障害予測、予測に基づいたメンテナンス提案なんかを定常業務に織り交ぜるなど、機械学習を取り入れることで業務負担を軽減できるはずです。

一年前は「AI」と言われて真っ先にターミネーターが思い浮かぶレベルだったので、今や Kaggle デビューを決意するに至った勉強会に感謝しかないです。会社のデータ分析基盤や機械学習の浸透に一役買っていきたいです。

*1:Kaggle:企業や研究者がデータを投稿し、世界中の統計家やデータ分析家がその最適モデルを競い合う、予測モデリング及び分析手法関連プラットフォーム及び運営会社を指します。

2021年度の新卒エンジニア向け技術研修を紹介します

TECHSCORE

2022-01-06 11:00:00

シナジーマーケティングでは2015年からエンジニアの新卒採用をしています。 当社では毎年、エンジニア全員で試行錯誤しながら新卒エンジニアの育成をしています。 この記事では、新卒エンジニア向け技術研修の中から講義の内容についてご紹介します。

松田 直哉(マツダ ナオヤ)

2020年シナジーマーケティングに新卒入社。

自然派エンジニアを目指して頑張ってます。

山登り/ダイビング/ボルダリングが趣味です。

当社の新卒エンジニア研修について シナジーマーケティングでは、新卒エンジニアがスムーズに業務に入っていけるよう、毎年研修を行っています。主に新卒2~3年目社員が「トレーナー」として研修を担当し、4年目以降の社員がそのサポートを行っています。これには以下の狙いがあります。

1年目社員(研修を受ける側)にとって 2~3年目社員は身近なのでコミュニケーションがとりやすい 次年度以降の業務をイメージしやすい 2~3年目社員(研修を提供する側)にとって 自身が新卒の時に失敗したことやつまずいたところのカバーをしやすい 指導するにあたって、これまで以上に技術の理解が必要になり、復習することで理解が深まる チーム運営やタスク管理の能力が身に付く シナジーマーケティングではリモートワークを積極的に活用しています。そのため今年の研修はほとんどリモートで実施しました。

新卒エンジニアは入社後、部署を問わず、共通するスキルや社内ルールなどを学ぶために社会人基礎の研修を受講します。その後、エンジニアとしての基礎を学ぶために外部の研修を受講します。外部研修が終わり次第、我々が内製化している新卒エンジニア向け技術研修に参加してもらいます。

社会人基礎研修 電話対応の行い方 /名刺交換の行い方 / 日報の書き方 社会人としての話し方 / プレゼンテーションのテクニック など 社外研修 Java技術研修(2020年度の実施内容) 変数、if文、for文など言語共通の技術 / オブジェクト指向 / データベース システム開発の工程 など 社内研修 講義(後述) 演習 Linux / データベース / WEBアプリケーション Docker / Git など 実践研修(OJT) 技術や社内ルールなどの知識がある程度蓄積された段階で、実業務を通じて実践的なことがらを学びます。 講義は1週間に2回程度、1回あたり30〜60分で行いました。

講義内容 この章では 講義名と内容の紹介、新卒へ伝えるための工夫点を記載しています。

講義ではシステム開発全体のことを知識として学んでもらいます。研修が終了すると新卒エンジニアはバックエンドやフロントエンドのチームに配属されます。更にその後はプラットフォーム、QA、PMと多様なポジションの業務を担当する可能性もあります。その準備のために、直近で必要になる技術だけでなく、どのポジションについても活躍できる人材となるために必要な技術は何かという観点から、これらの講義を選定しました。 講義名 内容、工夫点 Linux 基礎的なコマンド / 使用した業務例の紹介を交えて、実際に使用した業務や使うであろうシーンを記載して、用途を想像しやすいように Git(バージョン管理システム) バージョン管理システムとツールの違い、基礎的なコマンドと業務で使用するコマンドなど幅広く データベース 比較的初歩の概念(ACID特性、制約など)を多く含めて、初学者でも入り易く分かり易いように Webアプリケーション フレームワークや実際のコードについて セキュリティ 情報セキュリティや暗号技術のコアとなる要素について ネットワーク/Web基礎 TCP/IP、DNS、HTTP、REST などについて基礎的な解説 プロジェクト管理/開発手法 システム概要や設計などのドキュメント、PMやPLの役割、Issueやチケット管理、見積の精度を社内での使用方法を交えながら解説 マイクロサービス マイクロサービス、モノリシックという概念に加え、Docker、Kubernetesなどの技術について

マイクロサービスはSynergy!開発において重要な手法であるので、Synergy!での具体的な適用方法や、歴史的な経緯についても解説 API 一般的に使用されているAPIの規格や認証方法について

1点を細かく解説するのではなく、あえて広めに触れることで、各自で掘り下げる余地を残すように解説 フロントエンド HTML、CSS、React、Angular などについて

フロントエンドエンジニアの業務について1日の流れなどを混ぜて、1年後の自分を想像できるように、また、知識と業務の関係性などについて解説 運用・保守 保守と開発の違い、保守の監視ツールや脆弱性調査の方法を過去の事例を交えながら 品質管理 業務にすぐに生かせる具体的なテスト技法だけでなく、なぜ品質が大事なのかイメージしやすいように、障害事例を解説 クラウド(AWS) AWS Solution Architect Associateの試験範囲をもとにAWSの主要な機能や、はまりやすいポイント、コストなどについて まとめ 去年は2人で講師役を担当していましたが、今年は多くの人に講師役を担当してもらいました。 それぞれの得意分野を生かした講義内容となり、また、準備時間も多く取れるので、正確かつわかりやすい講義、資料ができたと考えています。質問などを通じて、良いコミュニケーションも生まれました。

改善点は、全ての講義を対面で行っており講義にさける時間も限られているため、深堀ができていないことです。 来年はいくつかの講義をビデオ収録し、講義数を増やしていければと考えています。

最後に 私も昨年の新卒研修をリモートで受けました。リモートワークの環境にも徐々に慣れてきたから大丈夫だろうと少し思っていましたが、始まれば上手くいかないことの連続でした。同じような資料を複数作成したり、研修課題を提出されてから課題の文章が悪かったことに気づいたり、進捗管理で把握できていない部分があったりと周りに助けを求めることがありました。ただ、先輩達からのアドバイスや新卒からの報告で大きなミスはなく伝えなければいけないことは伝わったのではないかと感じております。今年の反省を活用し、来年はさらに業務に必要な多くのことが伝わるように体制や資料をアップグレードしていきます!

一緒にシナジーマーケティングを盛り上げませんか? 現在、シナジーマーケティングでは一緒に働くエンジニアを募集しています。この記事を読んでシナジーマーケティングに興味を持ってくださった方は、ぜひこちらの採用サイトをご覧ください。

CTOが振り返るシナジーマーケティングの2021年

TECHSCORE

2021-12-20 11:00:00

2020年にCTOになって早二年。なんとか(おそらく)2021年もCTO として年末を迎えることができそうです。去年はいろいろはじめたもののまだまだ目に見えるものがなかったのですが、今年は変化の手触り(もふもふ?ごつごつ?)を感じられるよい年になりました。今年もシナジーマーケティングのエンジニアリングを振り返ります。

馬場 彩子(ババ アヤコ)

2001年入社のシナジーマーケティング最古のエンジニア(ほんとは2番目)。

オットと二人の息子と四人暮らし。息子、今年の誕生日は友だちと旅行にいくらしい。成長。でもちょっとさびしい。バースデーだからといっていつも特別なにかをしているわけじゃないけど。

すきなものはビールとカニ。きらいなものはチーズ。 シナジーマーケティングの2021年 Synergy!の2021年 Synergy! ではインフラのクラウド移行と、アプリケーションのモダナイズを実行しました。

インフラのクラウド移行は、2020年のアプリケーションのマイクロサービス化(コンテナ化)からスタートしました(そのときの話はこちら)。100以上あるサーバのコンテナ化をこつこつ進め、計画より遅れたものの2021年7月には作業を完了しました。 並行してAWS上の環境を構築していたのですが、2021年10月から移行を開始しました。2021年12月現在では、データベースの半分をAWS上に配置しており、AWSとオンプレのハイブリッドな環境でサービスを提供しています。引き続きデータや機能の移行を実施していき、2022年3月にはAWSへの移行が完了します。 クラウド移行、といっても、ふたをあけてみれば、ネットワーク、データベース、MTAから監視・ログシステム、CI/CDまで、アプリケーションコード以外(ほんとはアプリケーションコードもパフォーマンスチューニングでちょっと)の、すべてのシステムを再構築しています。移行期間中も大きな問題なく稼働しています。すごいです。

また、2005年にリリースしたフォームやデータベースの機能を「使いやすさを徹底的に考えた画面デザイン」でモダナイズするプロジェクトも進めています(そのときの話はこちら)。 フォーム Before(左) After(右)

フォームの設定はすぐに画面右側のリアルタイムプレビューに反映されます データ検索 Before(左) After(右)

行動履歴を条件にした検索、ANDとORを組み合わせた複雑な検索も可能に データ表示 Before(左) After(右)

ひとつの画面で顧客のさまざまなデータを閲覧可能に フォームもデータベースも多くのお客様に利用されている機能です。Synergy! はローンチから17年間、改変しながら提供し続けた結果、隠れ仕様が隠れミッキーなみに潜んでいる中、エンジニアが丁寧にシステムを分析、理解し再生していきました。終わりがみえてきた?!これもすごい。

プロダクトマネジメントに注力、新しいチャレンジも 今年はSynergy! の プロダクトマネジメント の整備にもチャレンジした一年でもありました。企画、PMM(GTM)、(社内)啓蒙の3機能を重点的に、再現可能なプロダクトマネジメントのフレームをつくろうと奮闘しました(奮闘記はこちら)。Synergy! のプロダクトとプロダクトマネジメントの深淵さと広大さに圧倒されながらも、yappli 連携などのいくつかの機能をリリースしたり、プロダクトの今を伝える社内情報共有のページをつくったり、プロダクトのアイディア・仮説を量産するプロジェクトを実施したり、プロダクトの意志をつむいでいく活動を実施することができました。

また、新しいサービスを2つローンチしたこともシナジーマーケティングのエンジニアリングにとって非常に大きな出来事でした。ひとつがSynergy! BCS、ブランディングを支援するクラウドサービスです。もうひとつがen-chantです。去年策定した新規ビジネス開発フレームに沿ってローンチした最初のサービスです。このときのことは以下の記事で紹介しています。

blog.techscore.com

また、その影でチャレンジしたがローンチしないという判断をしたサービスもあります。その判断をしたところも含めて、最初から最後まで当社で経験のないところにがしがしと獣道をつくってくれた取り組みだったと思います。詳しくは以下の記事で。

blog.techscore.com

思い起こすと去年の今ごろは世になにも出ていなかったんですよね。AWSインフラもなかったし、新しいフォーム機能もデータベース機能もなく、新サービスもなかった。やばい、本当に今年はいっぱいやったなあと思います。

ファンとともにSynergy を創造する 2021年のシナジーマーケティングはビジョン、ミッションの改定 からスタートしました。キックオフでは、全社ミッション「 Create Synergy with FAN 」にあやかり、現状のSynergy! というプロダクトに囚われることなく、我々のプロダクトを作ろう( = Create Synergy! )と話しました。

今期の開発は、前例や過去事例で思考停止せず、さまざまなものを能動的に解釈しなおし作り替えることができた一年となりました。システムも組織も情報(データ)が活発にとびかう健全な状態になってきたと感じます。

まだ終わっていないプロジェクトもありますが、来期の妄想を始めています。

まず、Synergy! です。 Synergy! は 間違いなくシナジーマーケティングの事業の幹だと考えています。17年サバイブしたからこそ、今は10 → 100のフェーズにいます。この段階に全てのサービスがたどり着くわけではなく、とても誇らしいのですが、もちろん前人未到の領域でもありません。もう一歩を踏み出すときです。Synergy! のインフラもアプリケーションも、よりCustomer Engagement を高める「使いやすい」ツールとして進化させたいと考えています。 また、来期はSynergy! バックオフィスシステムの刷新も目論んでいます。事業においてバックオフィス機能はとても重要な箇所です。Synergy! 自身の顧客体験、FAN体験をよりよくするために、取り組んでいきたいもののひとつです。

もうひとつ、新サービスは、ビジョン(人と企業が、惹かれ合う世の中へ。)・ミッション(Create Synergy with FAN ) をよりダイレクトに体現するサービスであってほしいです。今年リリースしたサービスも成長させたいですし、さらに新しいサービスもローンチしたい。事業の枝をしっかり広げていきたいと考えています。

こんなこといっていますが、今年も私自身は旗を振っていただけで、実際のところはよくできたチームが次のフェーズに成長して、終わろうとしています。来年もやっぱり期待しかないですね。引き続きよろしくお願いします。

エンジニアリングマネージャーが新規事業開発にチャレンジして得た気づきと学び

TECHSCORE

2021-12-17 11:00:00

この記事は Engineering Manager Advent Calendar 2021(その2) の18日目の記事です。

シナジーマーケティングではいくつかの新規事業開発に取り組んでいます。2021年8月にen-chantリリース時の開発についての記事がありましたが、en-chantと同時期にもう一つ新規事業開発に取り組んでいました。取り組んでいた、と過去形にしているのはすでに撤退判断をしたためです。この記事では、エンジニアリングマネージャー(以下、EM)の私がプロダクトオーナー(以下、PO)として新規事業開発をすることになった経緯や取り組んだプロセス、そしてチャレンジして得た気づきと学びについて書いていきます。

小野寺 俊也(オノデラ シュンヤ)

2015年3月入社のエンジニア兼エンジニアリングマネージャー

コーヒーが好き

最近のお気に入りは「冷やしピーマン」です。生のピーマンを氷水で一晩冷やしただけで苦味が抑えられて、さらにパリッとした食感もより強くなります。何をつけてもおいしいのですが、一番好きなのは塩です。 目次

新規事業開発をするに至った経緯 新規事業開発の顛末 体制 最初の事業企画プレゼンまでにやったこと 仮説検証でやったこと(LPテスト) 仮説検証でやったこと(社内MVPテスト) そして撤退判断へ 振り返り どう仮説を検証するかを考えてすぐ動く POは意思決定の連続 頭の中はかんたんに伝えられない EMがPOとして新規事業開発をする強みと弱み 新規事業開発チャレンジのその後 新規事業開発をするに至った経緯 はじめに、新規事業開発をするに至った経緯をかんたんに説明します。

私が所属するビジネスクリエーション部では名前の通り新規事業開発をミッションとしています。2020年4月頃に管掌役員から新規事業に関わる技術調査依頼のミーティングがセットされました。このミーティングでアイデアを出してみたところ、POとして事業開発を任せてもらえることになりました。

これまでEMとして働いてきた私が、事業開発にチャレンジしたのには2つ理由があります。

1つはEMとしてメンバーの活躍の場、成長の機会を創りたかったというものです。ありがたいことに私のグループには技術力も一定ありながら事業貢献への意識が強いメンバーが若手からベテランまで揃っており、いま進行中のサービスを3、4年安定して提供できている状態でした。新たな活躍の機会を作り、新しい人を迎えいれながら次の仕事をお願いするようなことをしたいと考えていましたが、当時はいくつか新規事業の種があったもののまだ開発フェーズではなかったため、私も事業開発をすることで開発フェーズに進める可能性を増やせるのではないかと考えたのが1つ目の理由です。

もう1つは個人としての純粋なチャレンジです。同じことをずっと続けるのが苦手な私は機会があればちょっと違う仕事をしてきました。当時はEMになってから3期目で、EMとしてもまだまだ未熟ではありますが、別の領域であるPOにチャレンジしたい思いが勝ったというのが2つ目の理由です。

新規事業開発の顛末 では、どういうことをして、なぜ撤退という判断をしたのか、というのを紹介していきます。 今回の事業開発のタイムライン

体制 今回の事業開発は私、エンジニア、デザイナーの3人で取り組みました。

最初の事業企画プレゼンまでにやったこと 事業開発を進める最初のマイルストーンとして2ヶ月後の管掌役員プレゼンがありました。どうプレゼンするのか検討もつかなかったため、まずはとにかく世の中の新規事業開発、スタートアップの情報を調べました。幸いなことにいろいろな方がプレゼン資料やその作り方を公開してくださっています。スタートアップピッチの資料をググるとAirbnbなどの海外企業の事例が多く見つかります。ですが、海外企業の事例はどうしても遠くに感じてしまうので日本企業の情報がないか探してみたところ、マザーズ上場企業の「成長可能性に関する説明資料」やTechCrunchのスタートアップバトルイベント、ICCのスタートアップ・カタパルトといったピッチ・コンテストで多くの事例を見つけることができました。最終的に 「Airbnb の初期ピッチ資料は YC の 3 分ピッチテンプレート通り」 に沿って検討・調査をすることにしました。

プレゼンの大筋のイメージができたあとの2週間は、エレベーターピッチやスケッチを書いてあとの2人に壁打ちをするというのを繰り返しました。何度かやりとりするうちに、少し筋の良さそうな仮説ができてきたので社内インタビューを実施して仮説の精度をあげていきました。私以外の2人はUXプロセスの経験があり、あっという間にインタビュー計画ができあがりました。インタビューの結果を受けてアイデアの修正を行い、架空のペルソナをつくりつつメンバー間の認識共有をしました。他にもベンチマークとなりそうなサービスの調査をしたり、仮説検証計画をMVPキャンバスに当てはめて作ったりしました。

チーム内でのターゲットの認識を揃えるためにペルソナを作成

どうにか作った資料でプレゼンをした結果、仮説検証を進められることになりました。

仮説検証でやったこと(LPテスト) いかに本質的な検証をするかが重要、と多くのスタートアップの書籍に書かれていたので私もどんな方法がとれるのかいくつか調べました。(この時点で本質的な検証が重要だとわかっていたつもりだったのに...)

その中で採用したのが、サービスが実在しているかのようなLPをつくり、ウェイティングリストにメールアドレスを登録してもらえるか、という市場の反応を見る検証方法でした。ストーリーマップ、上位下位分析、UXDコンセプトシートなどのコンセプトワークをしながら、どういった訴求にするのか、どうすれば実在するサービスだと思ってもらえるか、検討しました。そして、これらのワークを元に要求と機能を突き合わせて訴求内容を絞っていきました。コンセプトワークは1つ数時間程度で終わるものなのですが、メンバーそれぞれの頭の中にあるイメージは違っていることが多かったのでコンセプトワークを通じてすり合わせるのはとても有効でした。

LPでの検証結果はというと、Twitter広告4万円の出稿でCV 3件でした(CPAは...orz)。これでわかったのはペルソナに近いターゲット層がTwitterにどのくらいいるかというポテンシャルくらいで、他に得られたものはありませんでした。後々ペルソナに近い属性をもつメンバーが1名ジョインしてくれた際に、TwitterよりもInstagramをよく活用していることがわかったので、Instagramで試していたらまた違った学びがあったかもしれません。

蛇足ですが、LPを公開するためにサービス名を考えて商標登録やドメイン取得などもしました。今となっては本質的ではない不要なプロセスだったと反省しています。

仮説検証でやったこと(社内MVPテスト) 今回の新規事業開発ではスマホで使えるツールアプリを作ろうとしていました。今いるメンバーはスマホアプリの開発経験がなかったので、Reactができるエンジニアに加わってもらってReactNative/AWS Amplifyで実現可能性調査を目的とした開発をしつつ、実際に使ってみながらフィードバックをもらえるように社内MVPテストをすることにしました。なんとかReactNativeでの開発ができ、1ヶ月ほど社内MVPテストをしました。アプリならではの仕様に何度もつまづきましたが、結果的にすばやく修正を繰り返すことでテストをやりきりました。

テスト後に実施したアンケートとインタビューから、ユーザーに強い課題・強い要求がないことがわかりました。MVPテストの結果を受けてピボット案を検討していたところ、ふと、既存のアプリを使えば今回のMVPテストと同じ体験の検証ができることに気づきました。すでにあるアプリを使うだけなので社内MVPテストよりもっと早くもっと簡単に。事業開発当初から最小限に、最小限に、と思っていたのにも関わらず、アプリを作って検証してしまっていたのです。もちろん実現可能性の検証をすること自体は良かったのですが、体験の仮説検証自体はもっと早い段階でできたということに気づいたときには内心かなりショックでした。本質的な検証が大事だということは常に意識していたのに、実際にはできていませんでした。

そして撤退判断へ 初期仮説の失敗を受けて別のアイデアをいくつか考えましたが、どれも強いペインではないという結論になりました。また、当初のアイデアがソリューションから考えてユーザーを決めてしまっていたため、ソリューション仮説が外れた状態からピボットすることもできそうにありませんでした。サービスの利用者が一定増えることで成立するビジネスモデルを想定していたのですが、最初のユーザー獲得に対して予算投下したらどうにかできそうだという見込みも立てられませんでした。

振り返り 新規事業としては撤退という結果になってしまいました。それ以上に、新規事業開発のプロセスとしてもかなり失敗してしまいましたが、それでもいくつかの気づきや学びがあったのでご紹介します。

どう仮説を検証するかを考えてすぐ動く 新規事業開発のあらゆる書籍、サイトなど、至るところに「仮説」という言葉がでてきます。事業アイデアを考えているときは作り上げていく楽しさと同時に、本当にこれでいいのだろうかという不安がつきまとっていました。ここで失敗だったのは、アイデアを練り上げるフェーズに多くの時間を使ってしまったことです。もちろんアイデアを考えるには時間がかかってしまうのですが、最初のアイデアの確からしさをすぐに検証できなかったことが問題でした。頭の中でいくら考えて練り上げていっても所詮は自分の頭の中のことなので何一つ進展していないのと一緒なのだと思います。とにかく早い段階で想定ユーザーに持っていくのが大切で、ずさんなモノを見せる勇気が必要だと感じました。どう仮説を検証するかを考えてすぐ動くことの大切さに気づきました。

POは意思決定の連続 世に出したわけではないのでそれほど重要な意思決定はしていないのですが、事業開発は意思決定の連続でした。いままではPOにEMとして情報を渡しつつ最終意思決定をしてもらっていましたが、いざ自分がPOになってみると材料が揃いきらないままに意思決定をすることがとても不安でした。頭ではわかっていたつもりでしたが、POになってみて意思決定の大変さを学びました。

頭の中はかんたんに伝えられない 意思決定をするにあたって自分なりにロジックを組み立てるのですが、その過程は筋が通っているときもあれば、実は四六時中考えているものをこねくりまわしてつなげたものも混ざっていたりします。そして、こねくり回していることはなかなか自覚できないのが厄介で、筋を通して話しているつもりでもなかなか伝わらないということが何度もありました。幸いにしてメンバーがはっきりとわからないと言ってくれるので、齟齬があるまま進むということはありませんでした。こうした状況を避けるために、コンセプトワークはとても有効だと思います。数人が長い時間集まってやるので高コストに感じてしまいますが、ワークを通じて多面的に頭の中をアウトプットしつつ全員で共通認識を作れるのでコスパがいいと思います。

EMがPOとして新規事業開発をする強みと弱み 私がEMからPOになってみて感じた強みと弱みです。あくまでイチEMの例としてご覧ください。

強み

・仮説検証方法の引き出し:これまでの開発経験からどう作れば早くつくれるかというのは考えやすかったです。また、スクラムやMVP開発、UXプロセスなどエンジニアとして学習していたことが新規事業開発でも使えるものが多かったです。

・開発難易度の想定:開発観点での実現可能性の見積もりはこれまでもやっていたことなので、そのまま強みとなりました。

・実装要因:ちょっと開発の手が足りなかったり、LPを作ったり、といった場面で自分も手を動かすことでスピードを上げることができました。

弱み

・社外との関係性の少なさ:BtoBのアイデアについて意見をもらうべく企業にインタビューをしたのですが、私個人としては全くもってアテがなかったので営業社員に協力をしてつないでもらいました。

新規事業開発でPOをやるにあたってはEMだろうが他の職種だろうが、その時々で得意な領域や不得意な領域があるものだと思うので、すぐにヘルプを求めたり、体制づくりで自分の苦手を得意とする人に入ってもらったりするなど、どうにかして取り組むしかないのでしょう。

新規事業開発チャレンジのその後 撤退後、社内で新規事業へのチャレンジを促進するための座談会があり、失敗談として今回の記事に近い発表をしました。当初30分ほどの予定でしたが50分近く話してしまいました。少しでも学びを共有したかったから、というのは言い訳でタイムマネジメントができていなかっただけです。

座談会が終わってから数日後、他部署の方からちらほら開発ではない内容の相談してもらえるようになりました。これまではEMとして開発に関わる話をすることがほとんどでしたが、新規事業開発にチャレンジしたことで開発やEM以外で貢献できるものがあるのかもしれないと思えるようになりました。

この記事全体を通してEMとしての要素はほとんどなかったので最後にEMに関連することを書いて終わろうと思います。 もしPOや新規事業開発にチャレンジするかしないか悩まれているEMの方がいれば、ぜひチャレンジすることをおすすめします。そのままPOとして成功するのも素敵ですし、たとえ失敗してもPOというEMとは少し異なる視点で取り組んだ経験にはきっとEMとして活かせるものがあるはずです。

お世話になっているOSS開発者のスポンサーになりました

TECHSCORE

2021-10-28 11:00:00

2021年8月からシナジーマーケティングではOSS*1開発者、組織への寄付を始めました。

この記事では寄付をする(スポンサーになる)までの経緯と活動を紹介します。私は寄付をする際に必要な情報の調査、社内手続き、実際の寄付手続きを担当しました。

五十嵐 諒(イガラシ リョウ)

2021年4月入社のエンジニア。

毎日マクドでも飽きない。酒とゲームが好きです。

最近はサプリを摂りまくって免疫力を高めてます。最強です。 シナジーマーケティングでのOSS活用事例 シナジーマーケティングのプロダクト開発では多くのOSSを活用しています。

例えば、

Synergy!の土台を支えるコンテナオーケストレーションシステムとしてKubernetes オンプレミスへのKubernetes導入を振り返る - TECHSCORE BLOG 検証用のスマホをリモート化するSTF 出社不要!? 検証機をリモート化してストレスフリーに - TECHSCORE BLOG ユーザインタフェース構築のためのJavaScriptライブラリとしてReact Synergy! における Web フロントエンド開発の軌跡と将来の展望 | TECHSCORE BLOG このように、多くのOSSに支えられており、欠かせないものになっています。

寄付の動機 OSS開発者への寄付が簡単にできるということを知ったのをきっかけに、開発者に対する尊敬、感謝の意を行動で表すため、また継続的な開発をしてもらうための支援として寄附をすることにしました。

なお、これは社内Slackの雑談チャンネルで発案されたものが採用され、こうして全社の活動になりました。

寄付先の選定 寄付をするにあたり、まず大方針を決めました。

プロダクトを開発、運用する際に使用しているすべての OSSが対象 シナジーマーケティングとして外部に提供しているプロダクトで利用しているもの プロダクトに直接は含まれてはいないが、開発、デプロイなどで利用しているもの 大人数で開発しているものより、少人数で開発しているものを優先 予算はひとまず 10 万円 / 年 はじめてのことで何もわからないので、これはえいやで決めた予算です 継続して支援したいという思いを込めて、一括ではなく毎月払い 金額や期間については寄付される側の方で設定されるため、希望の金額・期間にできない場合もあります 寄付をするOSSの候補は社内のSlackで募集しました。

候補の中で寄付を募集していたものは2つありました。両方に寄付をしても予算内に収まるため、どちらにも寄付することにしました。

候補に上がった OSS に対し、

寄付を受け付けているか Web 上で簡単に寄付をすることができるか の観点で調べたところ、寄付を受け付けている OSS の数は多くはありませんでした。なんとなく(根拠はありませんが)もっと多くの OSS が寄付を受け付けていると思っていましたので、驚きました。

Evans Evansとは、gRPCクライアントツールです。gRPCサーバのRPCメソッドを呼び出して動作確認をする際などに利用されます。 多くのgRPCクライアントツールがある中で、当社エンジニアが普段使っているものです。

gRPC の CUI のクライアントツールを調べてまとめてみた | TECHSCORE BLOG

こちらはメルペイのエンジニアの方が開発しているようです。個人で開発をされているため、今回の寄付が、今後の開発に少しでもお役に立てばいいなと考えています。

OpenAPI Generator OpenAPI Generatorとは、OpenAPI SpecificationというRESTful API仕様の記述フォーマットに従ったAPI仕様書を基に、APIクライアントのコード、スタブサーバのコード、コンフィグレーションファイル、ドキュメントを自動で生成できるツールです。 Synergy!のメールAPIのインターフェースはOpenAPI Specificationのフォーマットで公開しています。この API 仕様書の開発や生成に OpenAPI Generator を使用しています。

Synergy! のメール API を使ってメール配信を行う | TECHSCORE BLOG

寄付の方法 Evans には GitHub Sponsors を使って、OpenAPI Generator には Open Collective を使って寄付をしました。いずれもそれぞれの GitHub ページでの指定に従っています。 両方ともOSSに寄付ができるプラットフォームです。

GitHub Sponsors 寄付をする方法はとても簡単ですぐにできます。 対象のOSSにあるこのボタンから進めていきます。

手順はGitHub公式ドキュメントに載っていますが、見なくても画面の案内に従えばできるくらい簡単だと感じました。

Open Collective OpenAPI GeneratorではGitHubでSponsorボタンをクリックすると外部サイト(Open Collective)に遷移します。

Open CollectiveでもGitHub Sponsorsと同様に寄付は簡単で、金額や期間、支払情報などを画面に従って入力していくだけで完了できました。

寄付完了 GitHub Sponsorsで寄付をしたらアカウントのページのSponsoringタブで確認できます。

https://github.com/orgs/SynergyMarketing/sponsoring

Open Collectiveの場合はアカウントのページのContributions(貢献)というところで確認できます。

https://opencollective.com/synergy-marketing#category-CONTRIBUTIONS

最終的な今回の寄付の内容は以下のようになりました。

OSS 金額 頻度 Evans $1 毎月 OpenAPI Generator $45.54(約5000円) 毎月 ※Evansの開発者は受け付ける寄付額を $1 に指定していました。

おわりに GitHub Sponsorsの存在を知ったことをきっかけに社内活動が始まり、ひとまず2つのOSSのスポンサーになりました。

企業としてのアカウントの持ち方、支払関係の設定や扱い等の調査や、社内の手続きがとても大変でした。利用規約をしっかり読んだり、社内のあっちこっちへ連絡を取って、いろいろ申請して... 会社として何かをする時はこうやってしっかりやらないといけないんだなと、とても勉強になりました。 GitHub SponsorsとOpen Collectiveでの寄付自体はどちらも直感的な操作で、ポチポチするだけで数分でできてしまうとても簡単な作業でした。

シナジーマーケティングでは今後もOSSへの寄付を続けていきたいと思っています。OSS開発者の皆さんのお役に立てれば幸いです。

*1:ソースコードの使用や改変等が無償で自由にできるソフトウェア

先輩たちを目標に邁進中。新卒2年目エンジニア、同期5人でこれまでの1年半を振り返る

TECHSCORE

2021-10-14 11:00:00

2020年4月に新卒入社したエンジニアは5人。 入社から1年半で経験したこと、目標にしている先輩のこと、これからやってみたいことなどを同期5人で語ります。

2020年4月新卒入社のエンジニアたち

登場人物

岸本 大河(クラウド事業部 第二プロダクト開発G、写真右下)

Synergy!のgiftee連携機能の開発やNEWT(後述)DBのサーバサイドの実装を担当。

岸本 和哉(クラウド事業部 第四プロダクト開発G、写真右上)

フロントエンドのチームに所属し、保守・バグの修正・要望対応などが主な業務。新卒1年目向けの研修や講義など育成関連の業務も担当。

松田 直哉(クラウド事業部 第三プロダクト開発G、写真左上)

Synergy!のファイル管理機能やフォームのカスタマイズなどを担当。他に技術職新卒のOJTなども担当。

松木 自然(クラウド事業部 第一プロダクト開発G。写真左下)

Synergy!LEADとLINEのバックエンド保守開発を担当。FROG(後述)のメンバーとしてチームで管理している移行業務を担当。

聞き手:小林 連(クラウド事業部 第三プロダクト開発G、写真中央上)

SIチームに所属し、複数の案件の保守対応や要望対応を担当。新卒の営業向け座学講座・育成などにも従事。

名字が同じメンバーがいるからか(?)、普段から名前で呼び合っている5人。この記事でも雰囲気をそのままお届けします。

それぞれの環境ですごした1年半。かつての不安や苦労が今の業務に生きている 小林(以下、連):

入社してもう1年半ですね。配属されて1年ちょっとですが、

それぞれどんな仕事をしましたか? 岸本 大河さん(以下、大河):

入社後の研修が終わってすぐgiftee連携機能(後述)の実装を担当しました。その後、Kubernetesへのアプリケーション移行を担当して、今はNEWT*1 DBの実装をしています。

岸本 和哉さん(以下、和哉):

去年の夏にインターンシップの企画と当日対応を担当しました。その後バックエンド業務で特定のお客様が利用するSynergy!連携機能の開発を担当し、その後はOrangeチーム*2で保守をしたり、新卒育成に関わったりしながらフロントエンド業務をしています。

松木 自然さん(以下、自然):

和哉くんと一緒にインターンの受け入れをして、その後オンプレミス環境のKubernetes化に従事しました。現在はSynergy!LEADやLINEのバックエンドの移行、Synergy!LEADのフォーム新機能の開発などをしています。

松田 直哉さん(以下、直哉):

最初に取り組んだのはSalesforce見積資料の改修で、グループが変わって社内のマネジメントシステムの改修をしました。現在はFROG*3の全体テストとカスタマイズ案件を中心にやっています。

連:

入社後、4月は総合職の同期と一緒に研修、5~6月は技術職研修があって僕たち5人はしばらく一緒でしたが、その後はNEWT、FROG、SI、育成など結構バラバラの業務をしてましたよね。僕自身は研修が終わって1~2ヶ月ほどSynergy!のテスト業務をして、その後SIのチームに入って今に至ります。その中でインターンの受け入れをしたり、営業職に対する技術的な知識をつけるための座学研修やOJTなどを担当しました。 みんなは今話してくれた業務の中で、

一番印象に残っている仕事ってどれですか? 大河:

僕はgiftee連携の実装です。苦労したことや工夫したことは以前ブログに書いたとおりですが、この仕事をしたとき初めてSynergy!の中身を触ったんです。知識も無くて何から始めていいのかもわからなかったけど、このときの経験が今のNEWTの業務に生きてると思っています。

自然:

僕はインターンの受け入れですね。どんなことをしたのかは僕もブログに書きました。コロナの影響で実施形態を考え直したり、企画も今までにない内容だっりで、「これまでと同じ」ということがなくて、和哉くんと時には言い合いもしながら準備しました。インターン参加者が期間内にアプリケーションを完成できるか不安でしたが、結果きちんと完成し、インターン生も喜んでくれました。苦労は多かったけどやってよかったと思っています。今の業務では新卒1年目の後輩たちと関わる場面はないですが、和哉くんや連くんのように新卒育成に関わる機会があれば、この経験が生かせるんじゃないかと思っています。

連:

インターン受け入れは僕も印象に残っています。自然くんが担当したインターンとは別で、HAL大阪の学生さんを1ヶ月間受け入れる就業型インターンシップを直哉くんと一緒に担当しました。いろいろ迷うところもありましたが、参加者が「最高だった」と言ってくれて嬉しかったです。

成長しながら足りない部分と向きあう 連:

この1年でいろんな業務に関わらせてもらいましたが、やっぱりまだまだ足りないと感じることが僕は多かったです。みんなは

自分に足りないと感じる部分ってどこですか? ちなみに僕は知識が足りないと思っています。技術面もそうだし、あとは用語もですね。出てきた単語がわからなくて、その場で会話を咀嚼できないこともあります。

自然:

いっぱいありますが、特に感じるのはスケジュール管理です。去年と比べて業務が圧倒的に増えて、一つのタスクに集中することより、複数のタスクを並行して進めることが多くなっています。全体のスケジュールが決まっているなかで、自分が管理しているタスクを自分でスケジューリングして進めていくべきなのに、それが出来ていなくて先輩に助けてもらっている状態です……。あとは問題の切り分けです。例えば障害が発生した場合、ログを見に行って、問題を切り分けて原因を特定する流れだと思うんですが、これはまだまだ出来ていないです。

大河:

人にものを伝える能力と自分からタスクを作る能力がまだまだだと思います。今はタスクをもらって、それを分解して仕事を進めていますが、これから後輩が出来たら仕事を教えたりタスクを振ったりする必要があります。ここはこれから鍛えていきたいです。

連:

足りない部分を挙げだすときりがないですよね(笑)。今度は逆を聞きたいです。

この1年で成長したことや、強みだと思えることはありますか? 大河:

学生時代含めこれまで少人数での開発しかしてこなかったんですが、入社して大人数・大規模なプロジェクトに関わることで、技術力や報連相など、基本的な能力が身についたと思います。

直哉:

相手の顔色を気にせず言いたいことが言えるのは強みだと思っています。ただ、オンラインでのコミュニケーションはやっぱりオフラインとは違うと感じていて、普通は1年間一緒にいれば、言葉の選び方や言い回しとか、相手に合わせたコミュニケーションがなんとなくわかってくるけど、オンラインだと全くわからないので難しいなと思います。

和哉:

強みかどうかはわかりませんが、以前先輩に「気づきが多いね」と言ってもらえました。フォームやバグなど些細なことに気づくことが多いらしいです。元々そういうところに気づきやすかったのか、成長して気づけるようになったのかはわからないんですが……。

連:

和哉くん目線で、僕たちについて気づいたことがあれば教えてください!

和哉:

連くんはすごく冷静だと思います。本人が「パニックだ!」とか言ってるときでも全然パニックに見えないというか、穏やかなまま何なくこなしているように見えます。大河くんと自然くんは新しいものを取り入れる力がすごいと思っていて、それが二人の技術力になっているのかもしれないなと感じています。直哉くんは切り込み隊長で、例えば僕が気になってるのに聞けないような場面でも直哉くんは色んな人に率先して聞いてくれます。だから一緒に仕事がやりやすいです。

連:

ちょっと恥ずかしいですが、自分では足りないところに目が行きがちなので、こうして言ってもらえるのは嬉しいですね。

常に相手目線の人、技術力があって頼られている人。そんな先輩たちを見習いたい 連:

この1年たくさんの先輩からいろんなことを教えてもらったけど、特に

この人が目標!という先輩はいますか? 直哉:

川島さんです。入社後しばらくメンターをしてもらっていたのですが、とにかく説明とか例えがすごくわかりやすいんです。どうしてわかりやすいのか考えてみると、相手目線で物事をみているからだと思います。常に相手目線。しかも喋り方がすごく柔らかくて、画面越しでも人の良さが見える気がします。

大河:

僕は学生時代に寺岡さんに会って入社を決めたので、そのときからずっと、寺岡さんが僕の目標です。圧倒的な技術力があって、マネージャーとして話もわかりやすいですし、色んな面で見習っていきたいです。

自然:

白川さんです。配属されてからずっと白川さんと一緒に業務しているのですが、フロントエンドとバックエンドをフルスタックでできるところや、問題解決能力が高いところに憧れています。育成という面でも、僕が何か質問したときには、直接教えるのではなく自分で答えにたどり着けるように導いてくれますし、そのための時間をしっかり取ってくださっています。だから白川さんのもとで業務できている有り難さを感じますし、白川さんに聞いたらわかる、という安心感もあります。おそらく周りの人たちもそうで、本当に頼られている存在なので、自分もそうなりたいと思います。

連:

それぞれの目標目指して頑張っていきたいですね。最後に、

これからやってみたいこと、後輩へのアドバイス・メッセージがあればぜひ教えてください! 和哉:

これまでは一つの業務に従事するというよりはいろんな業務に関わらせてもらってきました。今後はフロントエンド業務をがっつりやってみたいと思っています。現時点ではフロントエンドとバックエンド、どちらが好きなのか自分でもよくわかっていないんです。「自分はこっちに行きたい」というのを見極めるためにも、一度フロントエンドを集中的にやりたいです。

直哉:

AWS関連の業務をやってみたいです。将来性があると感じるし、AWSを使用したサービスも増えています。今後技術が進化していってもついていきやすいのではと思っているからです。 後輩にアドバイスできるとしたら、「困ったら助けてくださいって早めに言おう」ってことです。オンラインだと一人で何時間も悩んで時間を無駄にしてしまうので、早めに助けてもらうのが良いと思います。

大河:

1年目の皆さんとは今のところ接点がないんですが、来年には一緒に業務することが増えると思うので、そのときには楽しく仕事がしたいなと思います!

自然:

何でも相談できる先輩を一人見つけてほしいです。仕事をする上で悩んだりそれをなかなか言い出せなかったりといった場面があると思いますが、そんなときに周りを気にせず相談できる人が一人でもいると良いのかなと思っています。

連:

みんなと重なる部分もありますが、僕は早い段階から先輩たちとラフなコミュニケーションを取ってほしいなと思います。真面目な人ほど最初は肩肘張って頑張ってしまうと思うんですが、それが続くと自分も相手も気を遣い続けないといけなくてしんどいですよね。。「親しき仲にも礼儀あり」と言いますが、もちろん礼儀は忘れず、でも気軽に、僕たち含め社内の先輩とコミュニケーションが取れれば良いんじゃないかと思います。

今日はみんな話を聞かせてもらってありがとうございました。これからもたまに集まって情報交換や近況報告をしましょう!

僕たちやシナジーマーケティングに興味を持ってくださった方は、ぜひエンジニア採用ページものぞいてみてください。未来の後輩をお待ちしてます!

*1:NEWT(ニュート):シナジーマーケティングの主力製品である「Synergy!」のモダナイズプロジェクトの一つ。ローンチ以来変えずに運用してきたフォームやデータベースの機能を、2020年代の環境に合わせて再生するプロジェクト。

*2:Orangeチーム:Synergy!のファイル管理機能を担当するチームのこと。他に、Synergy!LEADやLINEなどを担当するBlueチーム、SIを担当しているGreenチームなどもある。

*3:FROG(フロッグ):NEWTと同じくSynergy!モダナイズのプロジェクト。Synergy!システムを柔軟性と拡張性に優れたクラウドに移行することにより、将来のサービスの進化に備えるプロジェクト。

6年目エンジニアが初めて開発リーダーとして新サービスを立ち上げた話

TECHSCORE

2021-08-30 11:00:00

2021/7/1に、当社初のtoC向け事業サービス「en-chant(エンチャント)」をリリースしました。

en-chantは、ファンの日常生活をスポーツチームの応援につなげることができる、新しい応援の形のサービスです。en-chantではファンがプロジェクトに参加することで、ファンの代わりにスポンサーからチームへ応援金が渡る仕組みを提供しています。

en-chantとは(詳しくはこちら) 私はen-chantの開発リーダーとしてジョインし、サービスコンセプトから要件定義/設計への落とし込みや、開発チームのマネジメントを主に行いました。この記事では、初めて新規事業の開発に携わった私が、感じたこと、気づいたことについて書いていきます。

土屋 江里佳(ツチヤ エリカ)

2016年シナジーマーケティングに新卒入社。

当社のメインサービス「Synergy!」の開発に携わったことのない稀な存在。

趣味は休日に動物園や水族館に行くこと。

開発スケジュール en-chantの開発にあたり、いつ頃どのようなことをしたのかをざっくり図で表してみました。

en-chantのプロジェクトは2020年8月ごろからスタートし、はじめはビジネスサイドの2名でサービスの企画検討を行いました(企画のエピソードはこちらをぜひご一読ください)。ある程度企画が固まった2020年11月ごろに私がジョインし、2021年1月にエンジニア2名がジョインしました。

図中(2月後半ごろ)の「セキュリティ基準・個人情報取扱基準の見直し」について補足しておくと、当社はこれまでtoBサービスのみを提供してきたため、今回のen-chantの開発を機に、toC観点で基準等を見直し整理しました。

全体の工期は約11ヶ月、そのうちサービスの企画が3ヶ月、調査や設計、検証等が6ヶ月、実装とテストが2ヶ月弱というスケジュールになりました。

ここから、en-chant開発を通じて得た学びをいくつかピックアップしていきます。

学んだこと、感じたこと プロジェクトの用語とターゲット サービスの企画段階で大まかに実現したいことが決まっていたため、要件定義も設計も早めにまとまりそうだと思っていました。しかし、メンバー間でミーティングを続けても、どこか腹落ちしないようなことが増えてきました。具体的には次のようなことが起きていました。

同じ言葉でも、メンバーによって意味合いが微妙に違っている。「自分はこんなつもりで話していました」というコミュニケーションが発生している。 メンバーによって、想定するユーザーの行動に違いがある。例えば、ある機能を組み込むことを考えているときに、エンジニアのAさんは「この画面遷移でユーザーは迷いなく操作できるだろう」と考える一方で、ビジネスサイドのBさんは「ユーザーがこの画面に到達したときに次のアクションで迷ってしまうだろう」と考えている。 よくよく話し合って結論を出しても、日が経つとこの設計で本当にいいのか疑問に思う。意見がブレやすい。 1つ目の対策として、単語とその意味をドキュメントで明記し、プロジェクトチーム内の共通言語として使うことを徹底するようにしました。単語の意味が些末な違いだったとしても、認識齟齬が起きるきっかけになってしまいます。コミュニケーションでつまずきがあったものの、早い段階でその機会を減らすことができたのでとてもよかったです。

2つ目と3つ目は複数の要因があると思うのですが、主な原因はターゲットとなるユーザー像の作り込みが甘かったことだと考えています。

今回の開発ではUXリサーチ会社の選定が必要になり、その分ユーザーインタビューの実施が後ろ倒しになったため、自分たちの想像だけで作成した簡易的なペルソナに後づけで情報を加える形になりました。要件定義や設計の議論をする段階でインタビューが終わっていれば、事実に基づく情報を使ってユーザーの特徴を固められていたかもしれません。

また、スケジュールの都合上、今回はユーザーインタビューを3人の方に実施しました。結果、ターゲットとなるユーザーの傾向が大まかに見られたものの、もう少し多くの人にインタビューを実施していれば、よりはっきりとした特徴をつかめていたかもしれません。

今回の開発を通じてtoCとtoBサービスの違いを感じたのですが、toBサービスは具体的な利用用途が決まっていることが多くユーザー像が固めやすい一方で、toCサービスの場合は利用ユーザーの対象がtoBよりも広く、ターゲット像がブレやすいと感じました。ターゲットの特徴をより深掘りして、全員で共通認識をもてるように心がけたいです。

初期リリースのスコープ 設計完了まで遅れていたものの、2月半ばの時点で主要な機能は固まってきていたので、ワイヤーフレームの作成などと並行してプロトタイプを作成していました。 プロトタイプが形になり、実際に動いているモノを見ると嬉しいし、アイディアが沸きやすくなります。POからも「あの機能も追加できる?」など要望が上がってきやすくなり、開発も(もちろん内容によりますが)できると回答していると、じわじわ機能要件が膨らんでいきました。

結果、追加する機能が大きくなりすぎ、2021年5月時点でこのままだと初期リリース日の7月1日に間に合わないことが発覚しました。

そこで、初期リリースの時点でen-chantというサービスがどうなっていれば良いか、改めてプロジェクトメンバー内で話し合い、その時点で不要な機能は追加機能としてリリースすることにしました。結果、無事に初期リリースを迎えることができましたが、ギリギリの調整になってしまったため、初期リリースのスコープを明確にしておくべきでした。

チームビルディング en-chantではチームビルディングとして次の2点を実施していました。

(1) 週に一度、チームメンバー全員でOKR*1を確認する。

自分のしていることが目標に貢献するのか見直すきっかけになりました。開発だけでなく、ビジネス側の目標も確認することで、チームの全体の指針にブレが生じにくくなりました。

(2)朝会や週定例は短い雑談をする。

業務のみの会話はどうしても硬いコミュニケーションになってしまいます。少しの雑談でも話やすい「場」ができ、心理的安全性を高めることができました。

逆に、研修やワークショップといった交流は行いませんでした。メンバーがほぼ同じ部署で、元々ある程度交流があったためです。

開発する上で意見の衝突はもちろんありましたが、全体を通じて建設的な議論ができたと思います。また、リリース後にチーム全体で振り返りを行ったのですが、「あれはよかった」や「次はこうしたい」など、お互いへの称賛や次のトライを前向きに検討できていたので、働きやすい関係が築けていたかなと思いました。

社内の横のつながり en-chantを開発するにあたり、専従メンバーの5人だけではなく、部署の垣根を超え30人以上の方に協力していただきました。協力いただいた内容は次の通りです。

UI/UXデザイン ロゴ/ブランドデザイン HTML/CSSコーディング ユーザーテスト 社内インタビュー レポーティング 規約/特許関連の整理 問い合わせ/オペレーション/請求関連の設計 テスト PMO Synergy!の設定 ※en-chantでは当社のサービス「Synergy!」を利用しています。 お客様紹介 新規事業開発をはじめてみると、思いがけないタスクが出てきたりと想像以上にやることが多く、専従メンバーだけでは2021/7/1のリリースには間に合わなかったと思います。協力していただいた社内の方にはとても感謝しています。

初期リリースが終わって 私がen-chantの開発にジョインしてからリリースまで約8ヶ月ありましたが、本当にあっという間に時間が過ぎていきました。毎日の変化が大きい新規事業の開発は忙しかったですが、メンバーや環境に恵まれたこともあり忙しさを楽しみつつ取り組むことができました。

また、ここまで反省を含めて色々と書きましたが、決してネガティブな気持ちはなく、「あ、今のこの状態は黄色信号だぞ!」と気付けるタイミングを体験できたのは、とても良い経験になりました。

もし、同じような状況で新規開発があったとして、「今よりもうまくできるか?」と質問されれば、自信を持って「はい」と答えることができます。スキル的にもまだまだですし、勉強しないといけないことはたくさんありますが...(笑)

これからはen-chantがより大きく育つよう、尽力していきたいと思います!

一緒にen-chantを盛り上げませんか? 現在、私たちのチームではUXデザイナーを募集しています。この記事を読んでen-chantに興味を持ってくださった方は、ぜひ↓の記事もご一読ください。

一緒にen-chantをより良く、より大きくできる仲間を募集しています!

*1:目標の設定・管理方法のひとつ。en-chantではチームで定めた目標(Objectives)に向けて、ビジネスと開発それぞれの観点で主要な結果(Key Results)を達成できるように動いていました。

副業のハードルがぐっと下がる、グループ会社のスペースエンジンで副業をはじめました

TECHSCORE

2021-07-29 11:00:00

2020年11月から株式会社スペースエンジンで副業をしています。この記事では、副業を始めたきっかけやそこで得た気付きを紹介します。 西岡 壮太郎(ニシオカ ソウタロウ)

2018年10月入社のフロントエンドエンジニア。

ReactやReact Nativeでの実装を担当しています。 筋肉系エンジニアを目指して、大阪⇔東京間を自転車で移動したり、週4回の筋トレをしたりしています。 トライアルへの参加をきっかけに副業開始 シナジーマーケティング(以下シナジー)では、社員の成長やチャレンジを後押ししたいという思いから、2021年3月に副業をオープン化しました。それに先立って、ペイフォワードグループ内での副業トライアルが実施されました。

私は2020年11月より、その副業トライアルのメンバーとして株式会社スペースエンジンが提供するサービス orosy(オロシー) の実装に参加しました。 orosyは、D2C・オンラインブランドに特化したB2Bの卸仕入れマーケットプレイスです。

フロントエンドエンジニアの募集でしたが、必須スキル(Nuxt.jsの利用経験)に対してマッチはしていなかったので、迷惑にならないか技術的な不安がありました。その不安を解消するために、カジュアル面談を組んでいただいて、スキルのマッチも含めてのトライアルという形で参加しました。

副業トライアルから現在まで 副業トライアル 副業トライアル時点では、いくつかのルールが設定されていました。

期間は1ヶ月間 月の作業時間は20時間まで シナジーの業務時間として業務にあたる 副業を実施する事での本業(シナジー業務)への影響や、技術的な不安の解消を目的としてのトライアルのため、シナジーの業務時間としてスペースエンジンの業務に参加しました。そのため、シナジーの業務が終わった後に残業のような形で副業を行うイメージが近いかもしれません。

スペースエンジンでは、主にNuxt.jsを使ったレイアウト調整などorosyのフロントまわりの修正を行いました。 シナジーでの業務ではReactを利用しているため、一日の終わりの良い頭のストレッチになったことを覚えています。

現在 2021年1月から正式な業務委託契約を結び、スペースエンジンからお給料をいただいて開発に従事しています。 トライアル時のようなルール設定は無く、働き過ぎによる影響をシナジーの業務に与えないという約束ごとがあるのみです。ですので、グループ会社間での副業という実感は少ないですが、タスク管理の手法や技術面などの共有やこの記事のようなコラボレーションを行う事ができています。

6ヶ月間の気付き 2020年11月からの副業トライアル、2021年1月からの正式な副業の開始から半年過ぎて、良かった事、シナジーに持って帰りたいものについて挙げていきます。

グループ内副業のハードルの低さ 1つ目は副業を開始するまでの、心理的、工数的ハードルの低さです。 個人で副業を開始するためには以下のような手順が必要であり、私は副業に興味があったものの、実際に副業を始めるまでには至りませんでした。

応募する募集企業の選定。 企業への応募、面接。不採用の場合はこれを繰り返す。 業務開始と実業務とのスキルマッチの確認。 副業トライアルでは、グループ内企業からの募集という心理的ハードルの低さや、1ヶ月間のトライアル参加でのスキルマッチの確認など、上記のハードルが無くなった感覚に近いものがありました。 この機会が無ければきっと今も副業を始めていなかったと思います。

業務時間の自由度 2つ目は業務時間の自由度です。 他社の副業募集を見てみると、最低週16時間の稼働時間が必要な場合が多く、生活スタイルによっては時間確保ができない場合も多いでしょう。 私も最初は月30〜40時間程度の稼働ができると考えていましたが、今現在では月15〜20時間程度の稼働しかできていません。 とはいえ、もっと働きたい希望もあるため自身の時間の使い方の反省が続いています…

という風に、働きたい時は働けるし、働けない時は少ない稼働時間でOKと、とても自由な働き方をさせてもらっていると感じています。

チケットの切り方 最後に担当タスクの工数の小ささです。 スペースエンジンでの副業を始める前までは、「副業先のプロジェクトに関わる=とても大きな仕事を任される」という先入観がありました。しかし実際はボタンのデザイン改修からInstagramとの連携など、自身の裁量や技術レベルに合わせての業務が行えています。

この様な自身の状況にあわせたタスクを選択できることによって、前項の副業トライアルや現在の月20時間稼働が実現できています。 これは、得意な領域や複数プロダクトでメンバーが活躍するために、シナジーでの業務でも改めてタスクの細分化について考えさせられる内容でした。

まとめ 副業を始めてみて 副業トライアルから、現在に至るまでを振り返りました。 この記事を書く前は「思っていたより副業ってハードル高くない」と、ざっくりとした感想しか持っていませんでしたが、記事を書きながら現在の働き方、トライアルの受け入れを振り返ると、スペースエンジンにはとても良い機会と環境を提供してもらっていると感じます。

最後に、スペースエンジンの代表でエンジニアの責任者である野口さんからコメントをいただいていますので、是非ご覧ください。

スペースエンジン代表 野口さんから 副業が両者にとってうまく機能するためには「互いの“副業への慣れ度合い”の把握」と「期待値をのすり合わせ」が非常に重要です。

そのため稼働時間が短い、スキルに不安があること自体は問題ではありません。それを副業先へはっきりと伝えましょう。 そして会社と副業者が、それぞれ達成したいこと、稼働時間、スキルから両者とって良い経験になるように務めることができれば無理のないパートナーシップを構築することができると思います。

orosyは新たな資金調達を終え、メンバーの採用を開始していますので、転職を検討されているご友人がいらっしゃれば是非ご一報ください。

エンジニア募集中! シナジーマーケティング、スペースエンジンでは一緒に働くエンジニアを募集しています。 ご興味のある方はシナジーマーケティング エンジニア募集サイト、スペースエンジン エンジニア募集サイトからご応募お願いします。

シナジーマーケティング エンジニア大調査2021

TECHSCORE

2021-06-17 11:00:00

シナジーマーケティングには約80名のエンジニアがいます。 CTOである馬場をはじめ、採用サイトや人事ブログに登場している社員もいますが、紹介できているのはほんの一部です。 そこで今回、シナジーマーケティング初となるエンジニア向けアンケートを実施しました。エンジニアたちの経歴、仕事の進め方やこだわり、さらにはプライベートのことまで、「シナジーマーケティングのエンジニアってこんな感じ」をまるっと紹介します。 【アンケート概要】

実施期間:2021年5月11~24日

対象:シナジーマーケティングのエンジニア

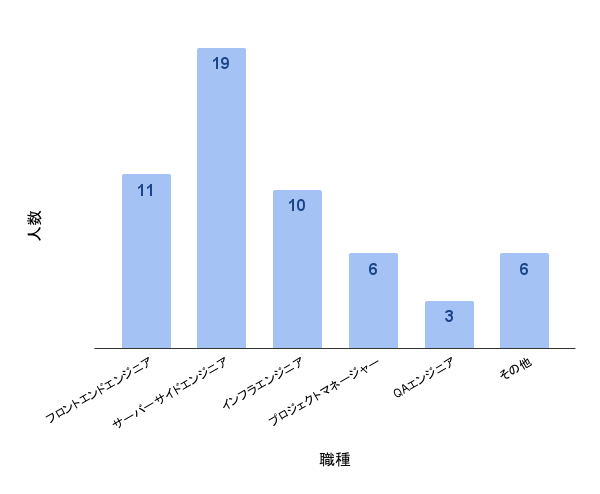

回答数:46 新人からベテランまで。多種多様なエンジニアたち まずはエンジニアたちの現在の職種、そして経歴や社歴について紹介します。

Q:あなたの職種を教えてください。(複数回答可) Q:あなたはエンジニアとして働いて何年目ですか?(企業への所属有無に関わらず、エンジニアとして働いた通算年数) Q:あなたはシナジーマーケティングで何社目ですか? ご覧の通り、エンジニアとしての経験年数では新人、中堅、ベテラン勢とまんべんなくいることがわかります(平均値は10.5、中央値は10)。ちなみに経験年数が3年未満のいわゆる若手社員は9名でした。社歴を見ると2社もしくは3社目の人で半数を占め、次いで1社目と4社目、それぞれ同じくらいの割合でいることがわかりました。「6社目」と答えたある社員に話を聞いてみると、エンジニアとしては15年目で、その中では当社が一番長いとのこと。長く働いてくれている理由として、制度面での働きやすさ、目の前の業務以外について提案できる環境、人の良さなどをあげてくれました。

また直前の職種を聞いてみると、多かった回答はやはりソフトウェアエンジニア。当社の主力製品であるSynergy!の開発に携わるエンジニアが多いので納得の結果です。ソフトウェア以外のエンジニアだった人やエンジニアでなかった人も少なくなく、中には「直前の前職」ではないですが以前探偵だったという異色の経歴を持つ人も。さまざまなバックグラウンドの人が集まっていることがわかりました。

誰かの役に立つことが嬉しい 続いて、仕事をする上でのスタンスや当社の良いところ&悪いところを聞いてみました。 仕事をしていて嬉しいと感じるときは、

エンジニア以外の方にありがとうをもらったとき お客様の課題解決に貢献できたとき お客様や仲間に感謝されるような仕事ができたとき、想定以上に早期解決ができたとき 誰かの役に立てたと思うとき、自分が成長したと感じるとき 自力で業務をやり切ったときや知識や経験が活かされたとき 自分で作ったものがリリースされ実際に動いているのを見るとき など、お客様など誰かに感謝されるのが嬉しいといった内容の回答が多く見られました。 また、これまで勤務した会社と比べたときにシナジーマーケティングの良いところとして、

人が良い 一人ひとりのスキルが高い 最新の技術を積極的に取り入れている 労働時間に無理がない(残業前提で予定を組まない) ばらばらではなく目標に向けて邁進している などの回答がありました。一方で悪いところとして

特定の人しかわからない、メンテナンスできないような状況がある 新人向けの教育体制や資料が薄い 優しすぎる、大人しい(もっとチャレンジしても良い) 業務の負担が偏っている 情報管理にかかわる制約が多い などの回答がありました。「人が良い」と多くが感じている一方で、それを「優しすぎる」と感じて、もっとガツガツしてもいいのでは?と考えている人もいるようです。また、社歴が長いあの人しかわからない……という問題はエンジニアに限らず各所にあり、そうした状況を改善する(そして未来の自分たちが困らないようにする)ために、最近は積極的にテキストで情報を残す人が増えてきています。

テレワークで仕事もプライベートも充実 最後にテレワーク体制でエンジニアがどう感じているのか、またこの1年で買ったおすすめのアイテムなどを紹介します。

以前「コロナで突然の(全員)在宅勤務。そのときエンジニアは?」の記事でも紹介したとおり、当社はコロナをきっかけに半ば強制的に在宅勤務をスタートしました。その後試行錯誤を重ね、2021年1月に在宅勤務(現在はテレワークという名称に統一)を正式に制度化しました。

現在もテレワーク中心の勤務状況が続いているなかで、プラス/マイナスと感じる点をそれぞれ聞いてみました。

<プラス>

通勤に時間や体力を奪われない 会議室問題からの解放 集中できる環境を作りやすい 分報でのつぶやきでコミュニケーションが生まれる <マイナス>

社員との雑談が気軽にできる場がないので、そういう部分ではコミュニケーションロスを感じる 運動不足 周りのタスクが見えづらいので若手へのフォローなどが難しい オンオフの切り替えが難しく、ずっと仕事をしてしまう プラス面では通勤時間がなくなったことによるメリット(家族と過ごす時間が増えた、趣味の時間を持てる、睡眠時間を確保できるなど)をあげる人が多くいました。また、出社すると会議室の予約や移動が必要となる、いわゆる「会議室問題」がこれまでエンジニアたちにストレスを与えていたことも明らかになりました。

また、最近買ったおすすめアイテム(サービス)としては

机&椅子 PC周りの小物(モニター、マウス、キーボード、ワイヤレスイヤホンなど) 映像配信サービス(Amazon Prime、Netflixなど) 家電(コーヒーミル、食洗機、オーブンレンジなど) 食関連(生協、Oisix、PostCoffeeなど) などの回答があり、自宅での業務の効率化や、おうち時間を楽しむために選んだモノやサービスが多くあげられました。

まとめ:まじめ&ポジティブな人多し 今回は当社で初となるエンジニア向けアンケートの結果を紹介しました。

経歴は本当に人それぞれで偏りがなく、エンジニアが互いに尊重し合いながら業務をする土台になっているように感じました。 また当社の悪いところやテレワークでマイナスと感じる点など、マイナスの側面を聞く設問では、匿名アンケート(名前は任意)にも関わらず思いっきり文句ばかりを書く人はおらず(笑)、「こうすればもっと良くなる」や「XXに気づけて良かった」など、マイナス面とその改善点・反省点をセットで回答する人が多くみられました。エンジニアに限らず、当社は「まじめ」とか「ポジティブ」と言われる人が多いですが、アンケートでも当社の特長があらわれる結果となりました。

ここではすべて紹介できませんでしたが、今回初めてアンケートを実施したことでわかったこともたくさんありました。これからもエンジニア一丸となって、お客様や世の中にとってよりよいサービスが提供できるように邁進していきます!

もっとシナジーマーケティングのエンジニアについて知りたい、という場合は採用サイトからお気軽にご連絡ください!

開発リーダーとしてチームビルディングのためにやったことを振り返る

TECHSCORE

2021-05-20 11:00:00

はじめまして、フロントエンドエンジニアの田中です。 2月にリリースした Synergy! フォーム機能 リプレースのβ版のフロントエンドチームリーダーを任されました。 リーダーという役割は初ということもあり悪戦苦闘した日々を振り返りたいと思います。

本記事はプロダクトマネージメントの手法などの話ではなく、リーダーとしてどんな気持ちで何に注力し、どんな行動を取っていたかという話です。

田中 賢樹(タナカ マサキ)

2019年6月入社のフロントエンジニア。

職場環境改善が大好物。

漫画/ゲーム/酒が好きです。

コロナで飲食店がすぐ閉まるのでつらい日々を送ってます...クラフトビール飲みたい🍺

このプロジェクトは Synergy!リリース当初から稼働していたフォーム機能を現在のモダンな技術でリプレースするというプロジェクトです。

フォーム機能は、フォームを作成し公開/非公開などの設定をする管理機能、作成されたフォームを実際に利用するコンシューマ機能に分かれています。私は管理機能のチームに所属し、フロントエンドエンジニアは私を含め5人体制でした。

Synergy!のフロントエンドは機能毎にリポジトリが分かれており、その多くはAngularが使われていますが、今回技術選定をするにあたってReact(Next.js)を選択しました。

様々な理由がありますが、大きなものは以下の2点です。

Angularは約半年に一度メジャーアップデートされるため、これに対応し続けることが苦しかった 私含めメンバー全員が別の技術に触れたかった 過去の資産が使えないデメリットはありますが、それ以上にメンバーのモチベーションを高め、生産性を上げることを選択しました。

チームとして目指したこと 今回特に目指したことは、メンバー全員が実装に集中でき成長できる環境作りです。

リーダーとしてフロントエンドメンバーの窓口になること以外、開発の進め方などは私個人に任されていました。 そこで、自分が開発者として働きたくなるような環境を作ることを目指しました。 それは、開発者が実装に集中できて、かつチーム全体で技術的に成長しあえる環境です。 実装のことだけに集中して思った通りの実装ができた時の快感はたまらないですよね?

リーダーとして心がけていたこと 今回私が心がけていたことは常にオープンであることです。

具体的にはいつどこで声をかけられても即レスすること、声をかけやすいように忙しさや疲れ、苛立ちなどを極力見せないことを心がけました。

私はチームで一番良くないことは、「一人で悶々と考え、時間を浪費してしまうこと」や「不満や疑問を言い出せずにため込んでしまうこと」だと考えています。些細なことでもとりあえず田中にぶつけてみれば話が前に進む、という印象を持ってもらうように努めました。

実際に何をしたのか 開発前1on1 メンバーはそれぞれ得意分野も違うし目指しているものも少しずつ違います。開発前に1on1をし、どこでバリューを出したいか、何にチャレンジしたいかなどをヒアリングして、チームとして共通認識を持つように努めました。

事前学習期間を設ける 今回はReactで開発することになりましたが、私以外のメンバー全員ほとんど未経験なので、約1週間の学習期間を設けました。やってもらったことは利用する技術のマニュアルやチュートリアルの確認です。意図は実装力をつけることではなく、どんなことができてどこに情報があるのかということを知ってもらうことです。

ライブラリ更新の自動化 開発中はライブラリの更新をいつするのかという課題があります。Synergy!のこれまでの開発でもこの課題に悩まされてきました。時間が経ってからいざ更新しようと考えても、色々なところが壊れてしまってサッと対応できず、想定外のリソースを取られてしまいます。

こういった課題を解決するために、ライブラリの更新を自動化するRenovateを導入しました。毎日自動的に更新の有無がチェックされ、自動的に更新、テストが行われます。テストに通らない場合でも、差分が少ないので小さな工数で対応することができました。これにより環境がどんどん古くなっていくという不安がなくなりました。

ページや機能毎の担当制を廃止 Synergy!のこれまでの開発では、ページやその中の大きめの機能毎に担当を分けて開発を進めていました。これは担当者がページや機能全体の責任を持ち、自分のやり易いように作るように考えられたもので、チーム内のコミュニケーションコストも低く着手までは早いです。

ただ、この方法はコードが属人化し易く、仕様の把握も自分の担当箇所のみで他の仕様に興味を持ちづらいという欠点があります。 また、チーム内のコミュニケーションコストは低いものの、他チームまで含めると関係人数が多くなり全体的なコミュニケーションコストは高くなります。

上記理由から担当制は廃止しました。その代わり

issue作成時に変更の詳細まで記述する 1週間毎にmilestoneを設けて、issueを整理する メンバー全員でissueを消化する という方針にしました。

担当制を廃止しても、自分が実装した内容に近しいissueばかり拾われて結局属人化するかも、という懸念がありました。 多少そのような傾向はありましたが、メンバーは未経験なものも含め、様々な領域のissueを消化していました。

リーダーはissue作成やコードレビューに徹底して、コードを書くことを諦める せっかくマージリクエストを出してもレビューが遅いと次のissueに集中しづらい状況になってしまいます。 普段からフロントエンドチームは担当プロジェクトに関係なく全員でコードレビューを行っていますが、各々がタスクを抱えているためレビューするまでに時間がかかる事も多いです。

そのためリーダーは即レビューを徹底しました。

これは開発メンバーの生産性を上げることにもつながりますが私自身、プロジェクトのコードがどうなっているかを完全に把握することができました。

しかし、リーダーとしてissue作成に加え、即レビューを徹底すると、それだけでいっぱいになってしまうことが予想できたため、自分自身はコードを書くことを諦めました。

結果として中途半端な対応にならずにサポートに回れ、メンバーの生産性、品質に貢献できました。

Slack通話の活用 コロナの影響で完全リモートの環境になり、基本的にチャットベースでコミュニケーションを取りますが、画面を共有しながら話した方が圧倒的に早い場面はとても多いです。 しかし、その度にわざわざスケジュールを確認してWebミーティングを設定するのも手間がかかります。 そこで活用したのがSlack通話です。

プロジェクトチャンネルやメンバーの分報などでちょっと話せますか?など一言いれた後にそこで通話を開始、画面を共有しながらペン機能を活用し、時に別のメンバーがフラッと入って来て別の視点から意見を出してくれたりと同じオフィスにいる場合とあまり変わらないシームレスなコミュニケーションをとることができました。

実際運用してみて まず、当初のスケジュールを伸ばすことなくリリースを迎えることができ、チーム内のモチベーションが終始とても高かったように思います。

コードから属人性がなくなり、バグ対応なども実装者が誰であれ手の空いているメンバーが率先して対応できる体制ができました。

また、現在はセカンド、サードリリースに向けてメンバーを再編成して開発が進んでいますがリファクタリングなども活発に行われ、開発速度も日々加速しているように感じます。

振り返り 今回心がけたことは以下の3点です。

要件を把握してissue化する。 迅速にレビューする。 突発的な相談の一次窓口になる。 最初はこれらすべてにカンペキに対応しようとして、私自身がキャパオーバーになってしまうこともありましたが、メンバーからのフォローに救われました。

要件のまとめ方、issue化のやり方、レビューどれも仕組み化することで改善できることがかなり多かったです。

現在、セカンド以降の開発ではそれらの課題を仕組みで解決する試みを進めており、人数は減りましたが、よりスムーズにプロジェクトが進んでいます。

まとめ 技術的負債を返済するためのプロジェクトに、スケジュール的な余裕がなく新しい負債を作ってしまったという話はよくあると思います。

今回私のやった事はベストな対応ではなかったと思いますが、セカンド開発を見る限り成長し続ける新しいフォーム機能の土台として世に送り出せたのではないかと思います。

今後もより良いプロダクト、より良い開発環境を作り続けたいと思います。

TECHSCORE BLOGをリニューアルして1年の振り返り

TECHSCORE

2021-04-15 11:00:00

TECHSCORE BLOGをリニューアルしてから早いもので1年が経ちました。この記事では1年間の活動を振り返り、特にやってきたこと・良かったことについて紹介します。

河野 健太朗(カワノ ケンタロウ)

気づけば在籍10年目となってしまいました。

趣味はけん玉とカメラです。最近はミラーレスカメラでの動画撮影に取り組みつつあります。 執筆者のサポートを充実させる リニューアル以前は基本的に執筆に関して、執筆者で記事の内容からスケジュール管理まで行う必要があり、負担が大きいものでした。そこで、リニューアル後は体制を新たにして運営チームが積極的に執筆に関与するようにしました。具体的には以下のようにワークフローや資料を作成しました。

執筆前の打ち合わせから公開までのワークフロー スケジュール管理や記事内容のすりあわせのテンプレート レビュー方法の整理 記事の方向性や大まかなフォーマット よりよい執筆体制が組めるよう記事ごとに試行錯誤しています。

年間23本公開した 月2本を目標としており、結果年間で23本の記事を公開できました。この数字は他社のテックブログやリニューアル前と比較すると決して多い数ではありませんが、できるだけコンスタントに公開できるようにしようと立てた目標です。実際やってみると今の体制では月に2本公開していくのが精一杯という感じでした。運営チームのメンバーはみな兼務で、特定の担当者に偏りがちでもあり運営の業務はけっこう難しいなと改めて認識しました。

記事のスタイルがなんとなくできてきた 1年を通してやってきた中で「こういう記事の書き方が良さそう」というのが見えてきました。

記事を書く前に、執筆者と運営のチームで認識合わせのためにミーティングを必ず行うようにしています。記事を書いてもらってから、書いて欲しかったこと書きたかったことが食い違わないようにするためです。その際、具体的なアドバイスとして「ポジティブな表現を心がけましょう」ということを強調しています。特に何かのテーマで振り返りを行うような記事だと「こうすれば良かった…ここは失敗だった…」といったネガティブな表現になりがちなためです。(この記事もそういうつもりで書いています!)

また記事の冒頭にある自己紹介欄も、執筆者の人となりを知ってもらえればということで設けることにしました。記述は強制的ではありませんが、いまのところ皆さん何かしら書いてもらっています。記事を書いた人のバックグラウンドがちょっとでもわかれば、記事に親しみが持てるのではないかと思います。

いろんな人との関わり リニューアルしてからは会社のテックブログというスタンスで活動できたため、製品の機能のリリース、開発プロジェクト、チームの取り組み、自社の研修などを記事として取り上げることができました。それらの執筆やレビューなど含めて社内では約30人に関わってもらいました。弊社だけではなくクロノス様(技術研修)やアマナ様(OPTMS CONTENTS)、イルグルム様(エンジニア交換留学)には記事のレビューを行っていただきました。

運営チームではエンジニア以外の参加があり、その観点から企画やレビューの幅や質が向上したと感じました。

テレワークでミーティングがスムーズになった テレワークによって会議室を押さえる手間がなくなり、東京・大阪での拠点間のギャップや、部署間のギャップを意識せずコミュニケーションがとれるようになりました。意図してそうなったわけではありませんが、ミーティングがスムーズになったと感じます。

今後に向けて 1年間やってきましたが、昨年末はアドベントカレンダーを実施しなかったり、もうちょっと突っ込んだ技術の紹介をするような記事が出せなかったりと課題はあります。とはいえ、まずは長く続けていけるよう自分たちのペースでやっていこうと思います。

出社不要!? 検証機をリモート化してストレスフリーに

TECHSCORE

2021-04-08 11:00:00

シナジーマーケティングでは検証の目的でスマホの実機を複数台所有しています。 コロナ禍で社員がリモート勤務になったので、スマホにもリモート勤務をしてもらうことにしました。 この記事では、スマホ検証機リモート化の検討から導入までを紹介します。

稲垣 直子(イナガキ ナオコ)

2015年1月より、主に Synergy!の QA(Quality Assurance)を担当しています。

品質に関わる仕事を10年以上しているせいか、プライベートでもバグを検知します。

愛犬、愛猫に癒される日々を送っています。

最近は運動不足を自覚し、健康のために毎日ラジオ体操を始めました。 出社しなくてもスマホ検証機を使えるようにしたい 新型コロナウイルス感染症の拡大防止対策の一環として勤務体制が変更になり、2020年2月末頃から在宅勤務をすることが増えました。 私の所属しているQAチームは、Synergy! 全般のテストをしています。 業務では頻繁にスマホ検証機を使いますが、検証機はオフィスにあるため、利用する際は出社しなければなりませんでした。 電車に乗って人の多い場所に行くことは、感染のリスクも高くなりますし、移動時間もかかります。 交通費だってかかります。

スマホ検証機をリモートで操作できるようになれば、出社の必要もなくなるんじゃないか? 満員電車に乗る必要もないし、通勤に時間を取られることもなくなります。 これは是非実現させたい!!と思い、スマホ検証機のリモート化を検討し始めました。

スマホ検証機リモート化方法の検討 スマホ検証機をリモートで操作できるクラウドサービスは色々ありますが、やりたいことができるのか、まず調査を始めました。

Synergy!はCRMシステムであり、伝える手段として「メール配信」「LINEへの配信」「Web」など、情報を集める手段として「フォーム」「アンケート」など様々な機能があります。

まず、機能要件を洗い出しました。

LINEのメッセージが受信できる アプリプッシュ通知が確認できる キャリアメールが使用できる フォームが表示できる 開発アプリのインストールができる リモートでスマホの検証ができるサービスは、Remote TestKit、AWS Device Farm、kobiton、MOBA Cloud など、色々ありました。 しかし、キャリアメールを利用できるサービスを見つけることはできませんでした。

Synergy!には、データベースに入っているメールアドレスに対してメールを配信する機能があります。 データベースには、キャリアメールも存在するため、私たちもキャリアメールの検証が不可欠です。 上記のようなサービスを利用することで便利になるのは間違いないですが、キャリアメールの検証のためには現在契約しているスマホ検証機も維持する必要があります。 それでは単純にコストが高くなってしまうので、他にも調査を進めたところ STF を見つけました。

STF(Smartphone Test Farm)とは STF はクラウドサービスではなく、オンプレミスにリモートスマホ環境を構築できるOSS(オープンソースソフトウェア)です。 元々は、株式会社サイバーエージェントで開発されたもののようです。

既にある社内のスマホ検証機を活かすことができるので、機能要件は満たせます。 無料で利用できるということだったので、STF を使ってスマホ検証機リモート化をしてみることにしました。

※ 利用する場合は、ライセンス をご確認ください

STF構成図は、下記のようになっています。 STF構成図 ADB(Android Debug Bridge)は、デバイスと通信するための多用途のコマンドラインツールで、adb コマンドを使用してアプリのインストールやデバッグなど、さまざまなデバイス操作を実行できます。 RethinkDBは、リアルタイムWeb向けに設計されたオープンソースのJSONデータベースです。 Docker Image は用意されていたものを使用したため構築に苦労はしませんでした。

工夫した点は、認証です。 STFにログイン画面はありますが、適当なユーザ情報でログインができてしまいます。 そのため、Google OAuth認証を使うことにしました。 誰が利用しているのか明確にわかるようになり、毎回手動でログインする手間をなくすことができました。

スマホ検証機は、物理PC(Linux)にUSBケーブルで接続していきます。 USBケーブルは、充電のみのものとデータ転送できるものがあります。 充電のみのUSBケーブルでは、STFは使えないためUSBケーブルを買い足しました。

スマホ検証機は、スマホ保管庫に入れて管理しています。 スマホ保管庫 現在は11台のスマホ検証機が接続されています。 スマホ保管庫に入れる検証機は、必ずバイブなしのサイレントモードにしましょう。 通知音やリモートで操作される度に音がすると、スマホ保管庫周辺の方の迷惑になります。 (出社している人から、何度も「鳴ってるよ」と連絡をいただきました。ごめんなさい。)

STFの画面は、下記のようになっています。 端末リスト画面では、接続されている検証機がどのような状態か知ることができます。 端末リスト画面 リモート操作画面は、実際に端末を操作する画面になります。 スマホ画面のタップ、スワイプなど直感的な操作ができます。 リモート操作画面 リリースの前後ではスマホでの検証が必要になります。 以前は出社して検証をしたり、検証機の持ち帰りや返却のために出社をしていました。 スマホ検証機をリモート化したことにより、QAチームの出社率は下がり、QAチーム以外のメンバーへの貸し出しも容易に行えるようになりました。

利用は他部署にも 無事検証機のリモート化が実現し、これは他部署にも使ってもらえるかもと思い全社に案内してみたところ、利用者が増えてこんな声をもらいました。

「PCのキーボードから入力ができるから、実際のスマホより操作が楽」

「キャプチャを自分のPCに簡単に保存できるので、エビデンスがとりやすい」

「QAチームのつくった検証機のリモート化めっちゃいい!前はこのために出社してたから。ありがとう!」

もともとは自分たちの業務のためにスマホ検証機のリモート化をはじめましたが、結果的に他の部署の方にも喜んでもらうことができました。 現在は、他の部署のスマホ検証機もリモート化しています。 スマホ検証機をリモート化したことで、出社が必要なくなっただけでなく、自宅や他拠点からの利用も可能になりました。 はじめに想定していたより、大きなメリットがありました。

さいごに スマホ検証機をリモート化したことにより、下記の実現ができました。

いつでも、どこでも、テスト可能な環境ができた (新たなサービスを契約したわけではないので)コストは増加していない (スピード感を持ってテストが行えるため)時間短縮になった 品質の仕事をしていると「KAIZEN」という言葉を良く使うのですが、Quallity、Cost、Deliveryという視点から見ても、スマホ検証機リモート化は良い「KAIZEN」だったのではないかと思っています。 QAチームは、仕様レビュー、テスト設計やテスト実施などを主に行っていますが、品質に関わることであれば何でもします。

VUCA(ブーカ)と言われる先の見えない時代、これが正解だ!と最初からわかっているものはないと思います。 時流を読んで時流に乗った新しいことを取り入れたり、挑戦したりすることはとても意味のあることだと考えています。

シナジーマーケティングは、自由にやらせてくれる風土があります。 与えられた仕事だけでなく、「今が最善とは限らない」と常に考え、小さなことでも「KAIZEN」していきたいと思います。

シナジーマーケティングでは一緒に働くエンジニアを募集しています。

株式会社イルグルム様との企業間エンジニア交換留学に行ってきました

TECHSCORE

2021-02-25 11:00:00

企業間エンジニア交換留学として株式会社イルグルム様に留学してきました。 この記事では、留学の経緯や内容、そこで得た気付きを紹介します。

末廣 雅利(スエヒロ マサトシ)

2004年入社のシナジーマーケティング最古参のインフラエンジニア。

学生時代から日常的に Linux を愛用。気がついたら Linux 歴が 25年を越えていました。好きなディストリビューションは Debian。

妻と猫との三人暮らし。趣味はマラソンとトレイルランニングですが、コロナ禍で家にいることが多くなったのでピアノを習い始めました。

企業間エンジニア交換留学 当社 CTO の

サービス・プロダクトを進化させられる組織になるためには、今もっている知識・経験を整理し習得するだけでは不十分 まだ知らないもの・出会ってないものに触れる「探索」のプロセスが必要である 探索に必要なのは「弱いつながり」である という思いから、人との出会い・交流を促すため、株式会社イルグルム様との企業間エンジニア交換留学を実施することになりました。

実は、株式会社イルグルム様とは 2018年に交換留学を実施しています(こちら、こちら)。このときはアプリケーションエンジニアが留学したということもあり、今回はインフラエンジニアである私に白羽の矢が立ちました。私は転職経験がなく、他社のインフラエンジニアがどのように働いていらっしゃるのか興味もあったので、留学にチャレンジしてみることにしました。

留学内容 留学の受け入れ先は「みらい基盤課」です。株式会社イルグルム様の主力プロダクトであるアドエビスをインフラ面で支えていらっしゃる部署です。

留学期間は1週間。初日はオフィスに出社したのですが、コロナ禍ということもあり翌日からは完全リモートでの留学となりました。

短期間で具体的な成果を出すのは難しいことから、活動はミーティングがメインでした。半分の時間がミーティング、残りの時間はミーティングのためのインプットや1日の活動の振り返りに充てました。

参加させていただいたミーティングは以下のとおりです。

部門やプロジェクトの定例ミーティング みらい基盤課メンバーとの 1on1 みらい基盤課課長との 1日の振り返り 1on1(毎日) アドエビスのシステム概要や運用業務に関するレクチャ みらい基盤課の課題に関する意見交換 私はあまり人と話さない質なので、この一週間で半年分くらいの会話をしたのではないかと思います。

留学で得た気付き 以下、留学で得た気付きを思いつくままに挙げていきます。

研修資料の充実 まず、研修資料がよくできていて分かりやすいことに感心しました。初日の半日ほどでアドエビスのシステムについて理解できました(ダニング=クルーガー効果かもしれませんが、早い段階で全体像が把握できたと思えるのはいいですね)。聞くところによると、新入社員向け資料整備プロジェクトを立ち上げてかなりの工数をさかれたとのこと、その後もプロジェクトメンバーを入れ替えながら更新されているとのことで、大いに見習うべきと思いました。

運用業務の効率 次に、運用の定常業務にかけている工数が当社の 1/5 程度であることに驚きました。システム規模は大差ないし、運用定常業務の定義が大きく異なるわけでもなさそうなので、どこに違いがあるのか関心を持ちました。この差を説明するには足りないのですが、当社と異なる点としては以下が浮かび上がりました。

数年かけて運用業務を整理し、手順を作って定常業務化されてきたこと 定常業務の時間枠を決めていること 割り切って廃止した業務があること 我々の状況を振り返ってみるに、慣習で続いている業務や歴史の積み重ねで重厚になったプロセスや手順が足枷になっているのではないかと思います。これまでも業務を見直してきましたが、もう一歩踏み込んでみてもよいかなと思いました。

セキュリティエンジニア みらい基盤課にはセキュリティ系の技術コミュニティで活動されているセキュリティエンジニアの方がいらっしゃいます。当社では WAF の導入・運用に苦労してきたので、どうすべきだったのか相談に乗っていただきました。1on1 の時間を全部使ってセキュリティに取り組むスタンスからはじめて、いろいろ教えていただきました。

その他 開発部門の全体ミーティングでは、各部署からの報告でそれぞれの部署メンバーの持ち回りで発表しているのが印象的でした。他部署のメンバーを知る機会になるのでよい方法だと思いました。また、ファシリテータの方の性格によるのかもしれませんが、和気藹々とした雰囲気のよいミーティングでした。

組織や業務上の課題についての意見交換では、当社でも同様に抱えている課題ばかりで共感しきりでした。 我々の経験も踏まえて話しましたが、やはり同じところに悩みがありますね。

留学で残せたかもしれないもの 逆に、留学中の対話の中でいくつか興味を持ってもらえたのではないかと思えることがあるので挙げておきます。

感想戦 将棋などでは対局後に指し手を再現しながら検討する感想戦というのがあります。この感想戦になぞらえて、技術的な観点から障害対応を振り返って経験の共有と学びにするという活動をしていました。ネーミングが前向きであること、反省ではなく技術を検討するための振り返りであることから技術者にとって取り組みやすい活動だったと思います。過去形になっているのは、日々の業務に追われてしばらく実施していないためです。この反省も踏まえて、資料の準備に時間をかけることなくライトな形で実施するのがよいこともあわせて紹介しました。

Reunir Reunir は当社独自のサーバ情報収集フレームワークです。名前はスペイン語で「集める」という意味の動詞からつけました。 各サーバに配備した Agent がサーバの情報(OS、各種リソース、導入済パッケージや稼働しているサービスなどの情報)を定期的に収集して Elasticsearch に投入します。Redash からその Elasticsearch を検索することにより集めた情報を利用します。脆弱性対応などで対象となるサーバを割り出すのに膨大な工数がかかった過去の苦い経験から作りました。先日の dnsmasq における「DNSpooq」脆弱性 の対応でも活躍してくれました。

技術力とは何か とある方との 1on1 で「技術力とは何だと思うか」という話題になりました。 私の回答は「技術力とは想像力である」です。

私自身、何かに失敗して「そこが問題になるとは気付けなかった。技術力がないな」と思い知らされることがあります。技術的にヤバそうな匂いを嗅ぎ分け、最善手を見出すことができるのが「技術力がある」ということなんだと思います。技術力とは何かを具体的に説明しているわけではないのですが、このように応用できる形で身につけてこその技術力だと思っています。

参加してみて 人と話すことが苦手でミーティング三昧は辛いだろうなと覚悟していたのですが、留学に関わってくださったみなさんがフレンドリーで想像していた以上に対話できました。当社と似ている点、異なる点、いろいろ勉強になりました。有意義で貴重な経験をさせていただきました。

唯一心残りなのは、ある方との 1on1。事前にいただいたお題が「新人なので、これからのインフラエンジニアに必要なことを知りたい」だったので「それはプログラミングです!」という回答を用意して臨んだら、その方がバリバリのプログラマーだったのには焦りました。頭がまっ白になってしまい、その後、何を話したのかも覚えていません。相手の方にとってあまり有意義な 1on1 にならなかったのではないかなと思います。申し訳なかったです。もしも、次に機会があればもう少しマシなお話しができればと思います。

コロナ禍でほとんどリモートでの留学でしたが、「弱いつながり」だけど確かなつながりを持つことができました。これを機にさらにつながりを増やしていければと思います。

さいごに シナジーマーケティングではクラウド基盤エンジニアを募集しています。「面白そう」と思った方、まずは話を聞きたいという方は、こちらからご応募ください。

データサイエンス分科会活動共有会🔬を開催しました

TECHSCORE

2021-02-16 11:00:00

シナジーマーケティング CTO の馬場です。2020年の年末、社内向けにデータサイエンス分科会の活動共有会を開催しました。

馬場 彩子(ババ アヤコ)

2001年入社のシナジーマーケティング最古のエンジニア(ほんとは2番目)。1番目が西尾です。

CTO になって早一年。ようやくCTOを名乗るときに噛まなくなりました。

カニLOVER🦀。先週末食べたばかりなのに既にカニロス。 データサイエンス分科会とは データサイエンス分科会は、データサイエンスのシナジーマーケティング事業貢献を目的に2020年8月に発足しました。デジタルマーケティングを展開する当社のデータサイエンスへの取り組みは10年以上と古く、OPTMS CONTENT など世に提供されているサービスもあります。企業と人とをつなげるためのさらなるデータ活用方法を探究すべく、ベテランデータサイエンティスト西尾、期待の新星桂川、そしてCTO 馬場の3人で密やかに活動をしていました。

共有会 サイエンティストだけでは事業に結びつけることはできません。技術を活用し、事業をさまざまな人と共創する土壌をつくりたい。そんな思いから、2020年12月に活動共有会を開催しました。

共有会では3人それぞれが、当社のデータサイエンスへの想いを語りました。

まず、私が過去のデータサイエンス事業を踏まえ、当社のデータサイエンス戦略の課題と今後の取り組みについてお話ししました。 次に、西尾が現在取り組んでいるデータサイエンス事業(OPTMS CONTENT など)と、そこで得たシステムの展望について語りました。 最後に桂川がメールマーケティングをエンパワーメントしたい、という想いについて話しました。三者三様、それぞれの個性もみえた発表だったと感じます。

ここで、当日の桂川の発表の一部を紹介します

桂川 大輝(カツラガワ ダイキ)

2019年新卒入社のエンジニア。最近、自然言語処理の門を叩きました👊

断捨離の門も叩いています。 マーケティングの民主化を実現する 桂川です。共有会当日は、「シナジーマーケティングにおいて貢献したい『マーケティングの民主化』」と題して、具体的な案や取り組みについて発表しました。

はじめに、「マーケティングの民主化」とは何かを紹介します。私が考える「マーケティングの民主化」とは、誰もが(どんな企業でも)高品質なマーケティングを実現できる社会を意味します。具体的には、マーケティングにおいて次の2点を進めることだと思っています。

作業の型化・自動化をし、マーケティングに継続的に取り組めるようにする 企業や担当者の間に存在する知識の格差を緩和し、初心者が「できなかったこと」を「できること」にする CRM施策を機能として利用できるようにする シナジーマーケティングも「マーケティングの民主化」に貢献していると思います。 例えば、企業と消費者がコミュニケーションするCRM施策を、クラウドサービスであるSynergy!の一機能として提供することで、誰もが施策を実行できるようにしています。

施策を機能として利用できるようにした例として、「ABテスト機能」があります。この機能のリリースにより、

すでにSynergy!でABテストを実施していた人:ABテスト実施にかかる手間の削減 ABテストを実施していなかった(知らなかった)人:ABテストの実施 が可能になりました。 このように、施策を機能化することで誰でも利用できるようにする、という点においては、Synergy!は「マーケティングの民主化」に貢献していると言えます。

他に貢献できる余地はあるのか そんなSynergy!ですが、マーケティングにおけるどんな工程に貢献しているのか整理します。ここでは、メール配信に焦点を当てて考えてみます。現状、利用者が検討・決定していると思われるのは以下の工程です。

目的・ターゲットの設定 配信内容の決定 メール詳細の決定 そして、Synergy!が配信自体を実行しています。

この時、利用者に依存する工程を削減し、貢献できる余地はあるのでしょうか?(“誰もが”を増大することができるのでしょうか?)私は、「メール詳細の決定」について、Synergy!がサポートできるようになると考えます。 メール配信をする場合、内容によってそのメールの効果(開封率など)が変わります。例えば、SuperOfficeのレポートによると、配信タイミング、件名の文字数、件名に入れる文字の種類などによってメールの開封率が変わることがわかっています。つまり、このようなこの経験者しか知らないメール作成の知識があれば開封率の高いメールを作成し届けることができます。 そこで、Synergy!で、「メール詳細の決定」の工程のサポートを機能で実現できないかと思いました。 これを実現するためには、まず経験者の知識をルールとして正しく理解する必要があります。

経験者の知識を機能にするために 経験者の知識を機能にするためには、次のような工程が必要です。

経験者の知識の理解 コンピュータが理解できる定量的なルールの発見 Synergy!の機能として実装可能に ここで特に難しいのは、「コンピュータが理解できる定量的なルールの発見」です。経験者の知識は複雑で定量的なルールの発見は困難です。例えば、メール詳細の特徴について、どんな件名・配信時間がいいのか、それが開封/クリック率といった効果へどれだけ貢献するのか、なんとなく説明できるものの、定量的なルールまで落とし込むことは難しいと考えられます。特に、ルールは定量的なものでないと機能としてコンピュータの行動の指標にできません。それゆえ、経験者の知識をルール化する手法が必要となります。

経験者の知識のルール化を実現する手法として、機械学習が挙げられます。機械学習とは、コンピュータが大量のデータを学習し分類・予測などに利用する技術です。 また、定量的なルールを自動的に構築することができます。定量的なルールを発見することで、ルールを定性的に理解できないコンピュータでも、ルールに基づいた行動の再現が可能になります。 そして、人間が潜在的に加味しているが、説明できない隠れたルールを発見することもできます。これを定量的に発見することにより優れた分類・予測が可能になります。つまり、データと機械学習により経験者の知識をルール化することができます。

例えば、メールの開封有無を予測することができれば、事前に対策をとることができます。メールの開封有無を予測するためには、「いつ、誰に、どんな内容で配信されたか」といった特徴とメールの開封有無の関係をルール化する必要があります。このようなルールを算出するためのデータとして、実際に配信されたメール群(配信履歴)、特にメールの特徴とメールの開封有無が考えられます。つまり、データと機械学習により「いつ、誰にどんな内容でメールを配信すれば開封されやすいか?」という経験者の知識のルールを発見できます。

まとめると、マーケティングの民主化とは、作業の型化・自動化、そして知識の格差の緩和を通じて、誰もが(どんな企業でも)高品質なマーケティングを実行可能にすることです。現状、CRMを機能として誰もが利用可能にしているという点において、Synergy!、そしてシナジーマーケティングはマーケティングの民主化に貢献しています。今後、それをさらに進めるための次のステップとして、機械学習を活用した経験者の知識のルール化・機能化することを提案しました。

フィードバックを糧に 再び馬場です。上記で紹介した桂川の発表は、当日も「機械学習のサービス実装のイメージが湧いた」と好評でした。オンラインで開催した共有会でしたが、技術を扱う部署からお客様に直接関わる部署などさまざまな部署から50人ほど参加した上、後日公開した録画を視聴した、という人もおり、この分野への関心と期待を感じました。 ただ、我々なりに丁寧に説明したつもりだったのですが、「難しかった」という意見も少なくありませんでした。アイディアを引き出すには、データサイエンスで何ができるのか、できないのかを理解する(してもらう)ことが非常に重要です。啓蒙活動も続けていかなければいけないと感じました。

今後 当社は今年、ビジョンとミッションをリニューアルしました。

VISION 人と企業が、惹かれ合う世の中へ。

MISSION Create Synergy with FAN

デジタルマーケティングでファンとの相乗効果(Synergy) を創る、というミッションを実現するには、データの活用が不可欠で、データサイエンス分科会はその技術的基盤となりたいと考えています。今年もよろしくお願いいたします。

「インセプションデッキを1日で仕上げる」に取り組んだ話

TECHSCORE

2021-02-11 11:00:00

2021年1月、シナジーマーケティングが提供する CRM サービス Synergy! の新オプションとして画像投稿機能をリリースしました!🎉🎉

この記事では、画像投稿機能をさらっとご紹介しつつ、この開発プロジェクトの立ち上げで取り組んだ「インセプションデッキを1日で仕上げる」についての感想をまとめます。

石田 一博(イシダ カズヒロ)

2018年11月中途入社

車が(運転するのも見るのも)大好きな化石タイプのおじさんに片足を突っ込んだおっさんです。

好きな食べ物はラーメン。苦手な食べ物はキウイ。

画像投稿機能 画像投稿機能とは、その名のとおり、Synergy!のフォームから画像を投稿できる機能です。 例えば、写真を添付して応募するようなキャンペーンなどに利用することができます。 投稿された画像はデータベース検索で顧客情報と紐付けて確認することができますし、投稿ファイルを一括でエクスポートすることもできます。 ※ 画像だけでなくドキュメントファイルも投稿できます。

これまでは「ファイル投稿フォームオプション」という名称で、当社でカスタマイズを請け負って制作していた機能ですが、これが管理画面から設定できるようになりました。

お客様(企業担当者様)からすれば、要件を伝えて、見積り内容を確認して、発注して…、という手間のかかる手続きが不要になりますので、「画像投稿したい」から「画像投稿できた」までの期間を短縮できます。

当社としても、要件を確認して、見積りをして、要員のスケジュールを確保して、カスタマイズして…、がなくなりますので、まさにWin-Winな機能なのです。

と、機能についてはここまでにして、ここからはプロジェクト初期の取り組みについて紹介します。

インセプションデッキの活用 もともとファイル投稿フォームオプションは、Synergy!の人気オプションの一つとして存在していました。 つまり、製品の機能として組み込まれてはいないものの、サービスとして既に提供している実績がありました。 もっと言えば、裏側の仕組みは既に存在していたわけです。 それをどうやってSynergy!の機能に組み込むのか、いつリリースできるのか、が焦点でした。 そして、時間をかけずにスモールスタートで始める、これも社内から求められていました。

初期段階では、従来の企画プロセスにのせてスケジュールを組み、企画だけで1ヵ月~1ヵ月半程度かかかる計算でした。 走り出しから「時間をかけずに」の壁に阻まれてしまったのです。 そこで、アジャイル開発のツールとして知られる「インセプションデッキ」を使ってみよう、となりました。

インセプションデッキは、アジャイルサムライという書籍で紹介されている、プロジェクトの内容を明らかにするツールです。 (インセプションデッキのテンプレートも公開されています。)

通常は数日から2週間程度かけてつくるインセプションデッキですが、これを関係者で集まって1日で仕上げよう! とチャレンジすることになりました。 当時は新型コロナの感染状況が少し落ち着いていたこともあり、会議室に集まってわいわい議論したのは良い思い出です。(※ディスタンス、飛沫、消毒、換気には細心の注意を払いつつ…)

その1日で目指すゴールは

プロジェクトに対する共通認識を全員で持つこと すぐに開発に取り掛かれるよう機能一覧をまとめること でした。

人は欲深い生き物ですので、インセプションデッキだけに満足せず、翌日から開発に着手できるよう機能一覧を作ってスコープの確定までやり切りました。

メンバーはPM、デザイナー、エンジニア、GTM(Go-To-Market)担当がメインで、そこにCTOと製品の歴史、仕組みに詳しいメンバーにも参加してもらいました。 参加メンバーをどこまで広げるかは色々な考え方があると思いますが、個人的には短期間で物事を決めて進めたいのであれば、Goを出せる人、リスクを冷静に判断できる人を巻き込むのが、とても有効だと思っています。

当然、事前の準備も大切です。 このミーティングまでに分担して現状分析をしましたし、エンジニアには実現イメージを膨らませておいて欲しいとお願いし、当日持ち寄って議論の材料にしました。こういった準備も結論までの時間短縮に役立ちました。

当日はインセプションデッキを作りながら、「これは機能一覧を仕上げてからもう一回考えよう」など、柔軟にアジェンダを組み替えながらメンバー全員で仕上げていきました。 午前11時から午後6時まで、休憩を挟みながら計6時間ほどかけて完成しましたが、あっという間の楽しい時間でした。 甘いものを用意すると、より捗るかと思います🍪

開発に着手できれば、あとは従来の確立された開発プロセスに沿って物事が回り始めます。 走り出しをコンパクトにするために、インセプションデッキは優れたツールだと実感しました。

もちろんこの取り組み方が、あらゆるプロジェクトで有効だとは思っていません。 今回のプロジェクトの特徴として

既に実績のある実現方法(処理方式)を用いる 業務フローも既存の仕組みに相乗りできる という点が挙げられます。 ゼロからの企画、構築であれば、実現方法やリスクの議論に相応の時間がかかるでしょう。

今後の展望 そんなチャレンジを経てリリースした画像投稿機能ですが、まだまだ生まれたての赤ちゃんです。 (裏側は実績のある仕組みなので、妙に老け顔の赤ちゃんかもしれませんが) ユーザビリティの面で改善すべき点はあるでしょうし、裏側の仕組みも最適化できると考えています。 今後はフィードバックを集め、より良い機能を目指して進化していきたいと思います。

また、開発プロセスとしても他のプロジェクトに生かせる取り組みだったと思いますので、良いところを当社の仕組みに取り入れていきたいと思います。

AWS ソリューションアーキテクト – アソシエイトへの道

TECHSCORE

2021-01-28 11:00:00

2021年1月にAWS 認定 ソリューションアーキテクト – アソシエイトを取得しました。 昨年AWS のトレーニングを受講し、その他の教材も利用しながら知識を習得してきました。この記事ではその学習過程や内容について紹介します。

山口 正寛(やまぐち まさひろ)

2014年より基盤の構築運用に携わっています。

辛いものが好きで、チャレンジと後悔を繰り返してます。趣味と呼べるほどではないですが、ランニングをコツコツやってます。 学習のきっかけ 私は普段プラットフォームエンジニアとして働いており、{物理,仮想}サーバの{構築,運用}の経験があります。AWS に関しても業務で取り扱った経験があり、

EC2を使ったサーバ構築 S3とCloudFrontを組み合わせた静的なwebページの公開 Route 53を使ったDNSの管理 など、従来インフラと呼ばれていたようなところの利用経験があります。しかし、

RDSやDynamoDBといった完全マネージドなサービス Lambdaのようなサーバーレスコンピューティング については利用経験がありません。

昨年後半、会社でArchitecting on AWSの受講者を募っており、今後のプロジェクトで必要になる知識を身に着け、知見を広めることができると思い手を上げました。(自己負担0円で3日間のトレーニングを受けれてHappyです。)

ソリューションアーキテクト – アソシエイト(SAA)とは 「AWS ソリューションアーキテクト – アソシエイト」とは AWS が提供しているクラウドの専門知識認定の一つです。 AWS 認定は分野とレベルによっていくつかに分かれていますが、上述したような自分の経験、知識、また将来目指したい方向性を鑑み、アーキテクト分野、アソシエイトレベルの認定に挑戦することにしました。 SAAは実務経験と幅広い知識が求められる、AWSを利用する技術者として自身のスキルを把握するには格好の試験だと思います。

トレーニングの受講 Architecting on AWS は座学とハンズオンの両方からなるトレーニングとなっています。S3を使った静的ウェブサイト構成から始まり、EC2、EFS、RDS、Route 53、VPC、ELB、AZ、サブネット、Auto Scaling、Memcached などのサービスを活用してシステムを構成する学習を行いました。 システム構築を進めていく中で

管理に用いるサービス(IAM、CloudWatch、Cost Explorer、CloudTrail、VPC フローログ、Systems Managerなど) 構築のためのサービス(CloudFormation、AWS クイックスタートなど) 疎結合アーキテクチャに用いるサービス(SQS、SNSなど) と、多くのサービスについても学習することができました。 今まで使ったことがあるもの、名前は聞いたことがあるけど使ったことがないもの、どちらも使う機会がありました。 (幸いにも全く聞いたことのないサービスは出てこなかったので、躓くことは少なかったです。) 実際に手を動かして、システム構築に対しての知見・スキルが向上した手応えを感じました。

受験することになった 3日間のトレーニングを受けたのだから、ソリューションアーキテクト – アソシエイトを受験、取得してみようという流れで受験することになりました。 トレーニングを受けて手応えを感じていましたし、試験問題サンプルの内容も理解し正解することができていたので「このまま行けるんじゃないか」なんて思ったりしていました。

模擬試験受けてみました とはいえ、本試験は15,000 円(税別)もするので、模擬試験 2,000円(税別)でまずは様子見してみました。 結果から言って、模擬試験は受けてよかったです。 試験の内容はNDAがあるので触れることはできないのですが、パソコンを使った試験で、紙の問題用紙を読む試験とは感覚が全く違いました。 サイトに公開されている試験問題サンプルは甘いです。模擬試験の問題は、サンプル問題と違って文章がもっと長く、内容も少し難易度が高いように感じました。

結果は、、、はい。模擬試験で合格ラインを下回っておりました。 どこがダメだったのかというと、トレーニングでは、どういう用途のときにそのサービスを使うのかといった学習はするのですが、そのサービスについて深堀りして学ぶということができていませんでした。(3日ですごい数のセクションなので仕方ないです。)

試験勉強始めました 模擬試験でどこが足りないかを掴むことができたので、試験に向けての学習をはじめました。 私の場合、以下のようなコンテンツを利用して学習に取り組みました。 AWSの用意するトレーニングライブラリや、書籍:AWS認定アソシエイト3資格対策で知識をさらに深め、チュートリアルを利用して実際に手を動かしてみました。 トレーニングのときにも思ったのですが、実際に自分で手を動かしてみると理解が深まると感じました。

AWSのアカウントを作成すると無料利用枠が付与されるので、無料で色々と手を動かしてみることができますし、AWSの用意するトレーニングライブラリも無料で利用できるコンテンツが豊富に用意されていました。

無料で使えるものを使って、効率的に学習することができたと思います。

本試験受けてきました 模擬試験同様、本試験もNDAがあるので内容には触れられませんが、注意点を共有できればと思います。

本人確認書類は2点必要!

ピアソン - 本人確認書類について に書かれていた(全然読んでなかった)のですが、運転免許だけではダメでした。 たまたまクレジットカード持っていたので事なきを得ましたが、2点必要なので気をつけてください。 会場についたらおさらいする時間はない

時間に余裕を持って会場入りしたのですが、到着すると受付に案内され、あっという間に手続きが完了します。

手続きが完了すると、予約していた開始時刻にならずとも試験端末に案内されたので、最後のおさらい(詰め込み)は会場到着までに済ませておくと良いと思います。 成績はその場ではわからない

最後に受付で紙を受け取りました。そこに成績が印刷されているのかと思っていたのですが、「結果が出たらメールでお知らせします」といった内容の紙でした。

コンピュータ試験はその場で結果発表だと思っていたので、結果が確認できるまではドキドキしていました。(渡された紙には結果が出るまで最長5営業日とありましたが、翌朝には確認できました。) さいごに ソリューションアーキテクト – アソシエイトの試験学習を通して、今まで使ってきたEC2、S3といったサービスについてより知識を得ることができました。また、複数のVPCやAZを使った冗長化、Systems Managerを使ったシステム管理など、基盤を構築し運用する上で必要なことを多く学ぶことができました。 今後のプロジェクトでは、今回の学習した知識を基に、安心・安全でかつコスト効率に優れた、良い基盤の構築・運用に貢献できればと思います。 AWSに限らずですが、技術は日々進歩しているので今後も学習を怠らず技術力を高めていきます!

シナジーマーケティングではクラウド基盤エンジニアを募集しています。

CTOになってはじめての1年を振り返る

TECHSCORE

2020-12-10 11:00:00

この記事は CTOA Advent Calendar の11日目の記事です。

2020年1月に シナジーマーケティング のCTOに就任し、1年が経とうとしています。本当はCTOA(CTO 協会)Advent Calendar のさまざまな記事にあるような、組織論や技術論を知的にかっこよく語りたかったのですが、書き下ろせるほど整理されたなにかが私の中にはありませんでした。ただ、年初より世界が一変したこともあり、去年まで一エンジニアだった私にとっては多くのはじめての体験と新たな発見があった1年でした。そんなこんなを徒然なるままに綴りたいと思います。

馬場 彩子(ババ アヤコ)

2001年入社のシナジーマーケティング最古のエンジニア(ほんとは2番目)。

オットと二人の息子と四人暮らし。急に息子が「小笠原、いきたいんだよね。行ったことないから」といいだしたので春休みに行くのを楽しみにしている。

すきなものはビールとカニ。きらいなものはチーズ。 シナジーマーケティングの2020年 シナジーマーケティングはクラウドCRM Synergy! を提供している大阪の会社です。この1年、当社のエンジニアはさまざまなことに取り組みました。

まず、Synergy! のモダナイズの大きなプロジェクトを二つ立ち上げました。 一つは、FROG (かえる)プロジェクトです。Synergy!システムを柔軟性と拡張性に優れたクラウドに移行することにより、将来のサービスの進化に備えます。二つめは NEWT (いもり)プロジェクト 。2005年のローンチ以来変えずに運用してきたフォームやデータベースの機能を、2020年代の環境に合わせて再生します。あわせて、UI統一と「使いやすさを徹底的に考えた画面デザイン」を実現します。この二つのプロジェクトは、海から陸へあがるように、Synergy! を進化させるプロジェクトとなってほしいという願いをこめて、両生類の生き物を命名しました。

各プロジェクトのロゴマーク

また、Synergy! では企業と顧客のコミュニケーションをリッチにするような機能( ABテスト 、データベースAPI 、シナリオ 、Jストリーム連携 、giftee for Business 連携 )も多くリリースしました。

新しいサービスの探索にもチャレンジしました。 当社はいままで事業部主導でのビジネス開発が多かったのですが、今期はエンジニア発信でデザイン思考に製品開発したり、当社の新規ビジネス開発フレームに沿って仮説の立案と検証を繰り返していたりと、サービスを産み出し育てていくプロセスでいろいろな試行をしています。

今期はエンジニアリング教育にも真正面から取り組みました。TADPOLE (おたまじゃくし)と名付けられたこのプロジェクトでは、総合職向けIT研修・技術職向け新人研修 から22新卒向けインターンプログラム まで、「エンジニア」「育成」というキーワードで語れるあらゆるものの整備と仕組み化をしました。

当社では古くからデータサイエンスに取り組み、OPTMS などのサービスに還元されていますが、よりデジタルマーケティング をエンパワーメントするためにシナジーマーケティングでどのように取り組んだらいいのか、議論をスタートさせました。

もちろん、TECHSCORE BLOG のリニューアル も今年の成果です。コードに現れないエンジニアの七転八倒・試行錯誤が言語化され、私たちの財産になっていると感じます。

選んだものが作品になる 私は、自分のもてるスキルを駆使して開発したサービスが、世に出て顧客(社会)に利用されることがエンジニアリングの楽しみだと思っています。そんな風に技術で世界を楽しくするよう、コアプロダクトをワクワクする今のテクノロジーで再構築したり、顧客によい驚きを与えられるようなサービスを企画したり、次の技術を模索したり、人財を育成したり、いろいろ進めてきた1年でした。

もちろん実際にエンジニアリングで事業を動かすのは当社のエンジニアです。この中でCTOの役割は人と人とを繋ぎゴールを示すことです。そのため必然的に多くの人に意志を伝えたり、さまざまな人に意見を求められたりすることが多くありましたが、「これだ」「こうしよう」と選ぶことをこわいと感じることもありました。ビジョンだったり方針だったり、自分の選択をぱちっと自信をもって示すことができず、まわりくどくエクスキューズしてしまう。

「なにがこわいのか?」と胸に手をあてて考えてみると、それは失敗ではなかったりします(いや、それももちろんこわいですが)。まさに心理的安全性の4つの不安(無知、無能、邪魔、ネガティブだと思われたくない)を感じているんです。【最高】技術責任者なのに!むしろメンバー時代の方が自由に発言していたと思うくらいです。ただ当社のエンジニアは率直に「馬場さん、それは違うのでは」と言ってくれます。なので、私は、自身の評価は気にせず、指摘や批判された場合も、ただ対策をうつか、選択を変えればよいだけなんですよね。

さて、突然ですが、ブルーピリオド をご存知ですか?息子に「美大、受験したら?」と言って冷たい目で見られるくらい大好きな美大スポ根青春漫画です。この漫画に、大学の授業の課題に悩む主人公に対して美大の猫屋敷教授が「君は作品をつくったことがない」と語る場面があります。

ブルーピリオド / alu.jp alu.jp ブルーピリオド / alu.jp alu.jp

エンジニアもサービスを生み出すクリエイターです。問い、吟味して、検証して、繰り返して、選んだ先にしか我々の作品(サービス)がないのだとしたら、不安に反応し選択をさけて、ブレーキをギュッと踏み込んでいる場合じゃないなあ、と思います。頭ではわかっていてもクッと止まってしまうのが人ですけどね。選んで選んで選びまくるのだ。

そんな感じでCTOの最初の1年は終わろうとしていますが、自分への前向きな落胆に比して、当社のエンジニアに対しては期待しかないです。2021年もいろいろ仕掛けを考えているので、いっしょにわいわい楽しみましょう。2020年おつかれさま & ありがとうございました。

シナジーマーケティング株式会社では一緒に働く仲間を募集しています。

giftee for Business 連携機能をリリースしました

TECHSCORE

2020-12-03 11:00:00

2020年11月、シナジーマーケティングが提供する CRM サービス Synergy! の新機能として giftee for Business 連携機能をリリースしました。この記事では機能の説明と開発時の苦労した点や工夫した点、初めて開発に参加した私自身の感想についてお話しします。

岸本 大河(キシモト タイガ)

2020年4月入社の新卒エンジニア